![图片[1]-劈柴哥和哈萨比斯亲自站台!谷歌世界模型Project Genie刷屏,幕后团队揭秘60秒不是极限,内存是巨大约束-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260131012749151-1769794069-d7c4ac7aa2487b9534a3f4e8463cc4be.png)

世界模型真的变天了!

今天,谷歌正式发布重磅世界模型原型产品“Project Genie”,只需一句话或一张图,就能一键生成可玩、可交互的实时虚拟世界。 它的重磅程度,让谷歌“掌舵人”劈柴哥和 Google DeepMind 创始人哈萨比斯亲自为它站台。

在 Project Genie 生成的虚拟世界中,你可以用 WASD 键移动角色、旋转视角、跳跃,在生成世界自由探索。更重要的是,其生成画面的精细度、整体完成度,已经明显超出以往研究型 Demo 的范畴,在观感上直逼成熟游戏产品。

过去几年,世界模型一直被认为是通往 AGI 的重要路径,但始终存在一个根本问题:它们更像会动的视频,而不是真正的环境。

具体来说,早期世界模型普遍存在几大短板:

-

生成世界质量偏低,结构简单

-

难以实时交互,或只能交互一两步

-

长期一致性差,画面和规则会“漂移”

-

不符合物理和因果逻辑,更像梦境而非世界

而 Project Genie,第一次把这些问题同时拉到了可用水平。

Project Genie 是一个基于 Genie 3、Nano Banana Pro 和 Gemini 构建的原型 Web 应用,其中的核心是谷歌最新的世界模型 Genie 3。

与以往“先生成完整视频”的方式不同,Genie 3 采用 自回归生成机制:它会根据世界描述和用户操作,逐帧生成环境状态,而不是播放预先生成好的内容。

这带来了几个关键变化:

-

长期一致性 生成的世界可以在数分钟内保持稳定,不会快速崩坏;系统还能“记住”用户造成的关键变化,记忆时间最长可达约一分钟。

-

真正的实时交互 世界以 20–24 帧 / 秒运行,用户的操作会即时反馈到环境中,而非触发预设结果。

-

更高质量的视觉表现 生成画面分辨率约为 720p,整体真实感和细节水平明显高于以往世界模型,为智能体理解复杂环境提供了更可信的视觉基础。

谷歌早在 2025 年就 将 Genie 3 称为“通往 AGI 的关键一步”。而在 Project Genie 的官方页面中,谷歌再次强调:

Genie 3 让智能体能够预测世界如何演化,以及自身行为如何影响世界,这是实现推理、规划和现实行动的基础。

可以说,在 Project Genie 身上,已经释放出一个非常明确的信号:世界模型正在从长期的前沿研究方向,正式迈入可落地、可探索的关键阶段。

一旦世界模型能够稳定生成高质量、可交互、具备长期一致性的环境,其应用边界将被迅速打开。

无论是自动驾驶中的复杂场景模拟、具身智能的环境理解与决策训练,还是游戏开发、影视制作、互动教育与新型媒体内容创作,世界模型都展现出极具想象空间的潜力。

据 The Verge 报道,谷歌选择在这一时间点推出 Project Genie,部分原因在于希望观察用户的真实使用方式,从而发现此前尚未预料到的新应用场景。

Google DeepMind 产品经理 迭戈·里瓦斯透露,谷歌内部已经对 Genie 在 电影制作、互动教育媒体 等领域,帮助创作者进行场景可视化与世界构建的潜力感到兴奋。

目前,Project Genie 仍是实验性产品:

-

单个世界最长探索 60 秒

-

分辨率约 720p,帧率约 24fps

-

仅向美国地区、18 岁以上的 Google AI Ultra 订阅用户开放

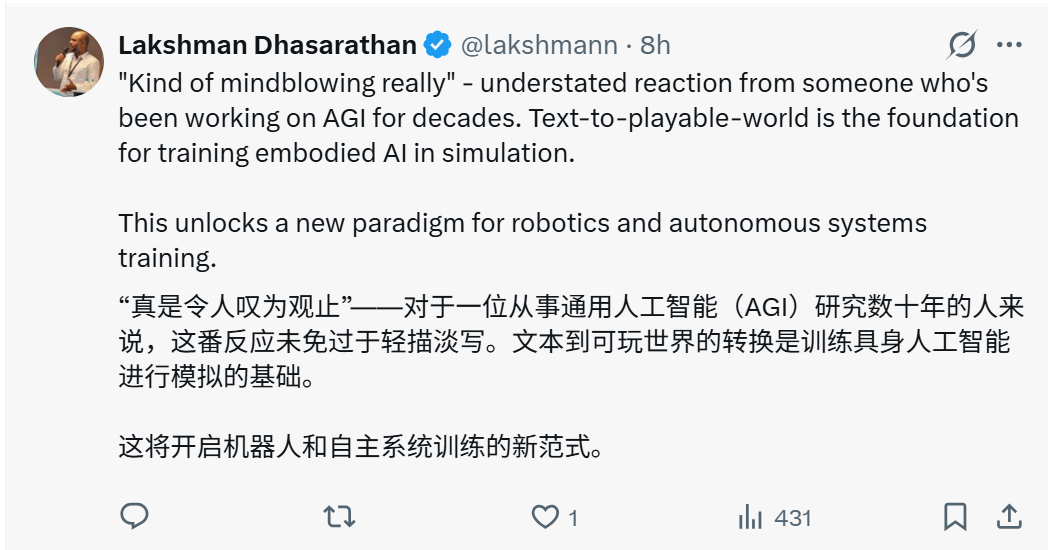

Project Genie 发布后迅速引发热议。马斯克第一时间发文祝贺

关于 Project Genie 的讨论,也在 X 上迅速扩散,不少网友将其称为又一个“变革时刻”。

对此,Project Genie 负责人之一 Jack Parker-Holder 表示:

Genie 3 感觉像是世界模型领域的一个分水岭。我们现在可以生成任何可想象世界的、持续数分钟的实时交互式模拟。这可能正是具身通用人工智能此前缺失的关键一环。

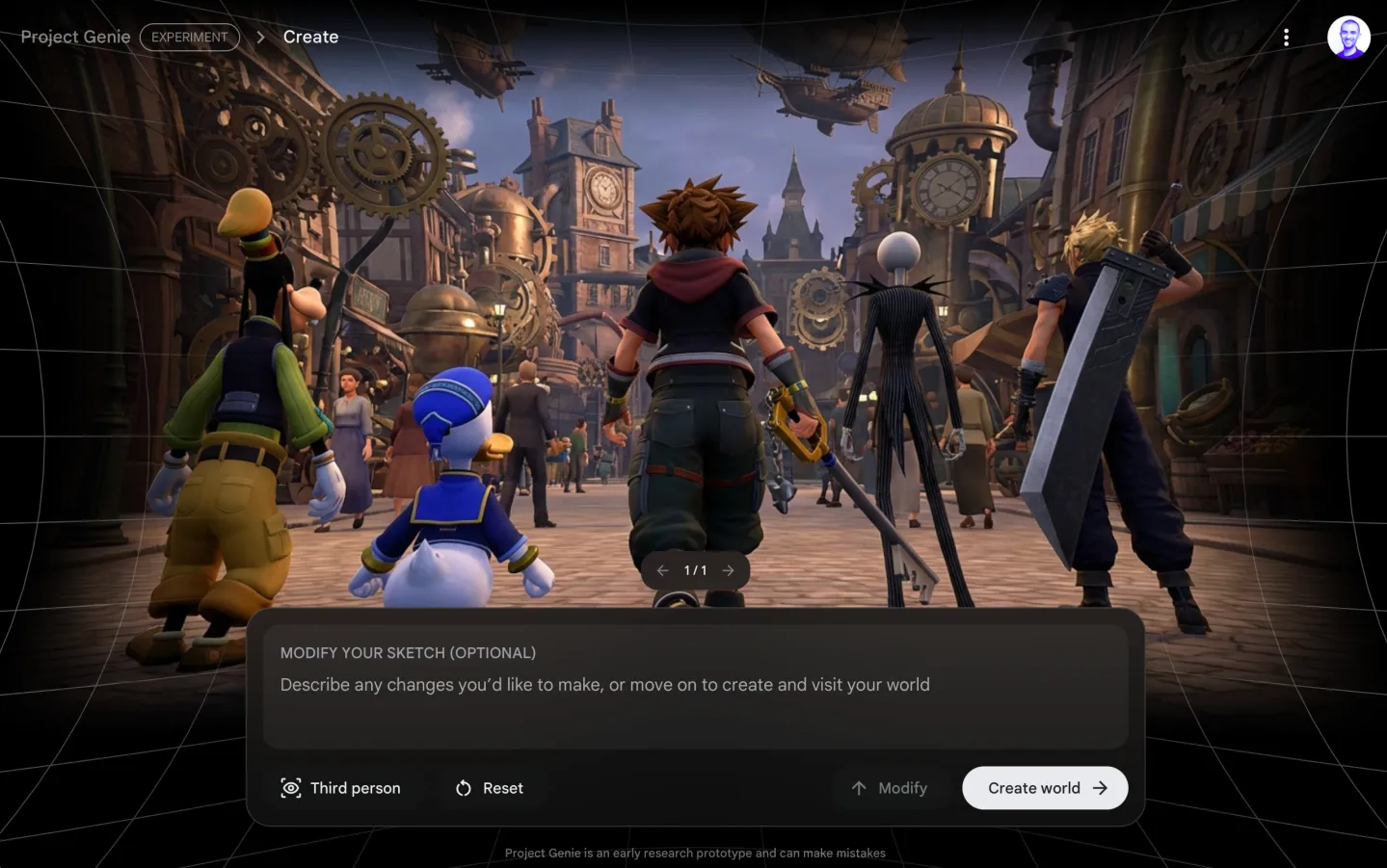

具体来看,Project Genie 的使用流程并不复杂。进入页面后,用户可以直接从 Google 预设的多个世界模板中选择,也可以完全自定义环境和角色,构建一个专属的虚拟世界。

为实现更精准的控制,Project Genie 会用 Nano Banana Pro 的能力,先为生成世界打个“草稿”。

整个页面被清晰地分成左右两部分:

-

左侧用于填写环境的 prompt,例如地形结构、视觉风格和整体氛围;

-

右侧则用于描述主角的形象与设定,并可选择第一人称或第三人称视角,从而提前确定进入世界后的体验方式。

完成初步设定后,Genie 会先生成一个缩略图,可以对生成内容进行预览和微调。如果符合预期,就能进入生成世界,开始实时交互与自由探索。Genie 3 的响应延时非常低,在控制角色移动时,会带来强烈的沉浸感。

在官方案例中,你可以把自己变成一个球,在草原上自由滚动。

可以看到,如果转换视角,球滚动留下的痕迹并不会消失,新生成的内容也不会覆盖旧区域。这一细节直观地体现了 Project Genie 所强调的世界一致性。

在另一个官方案例中,你可以变成刷墙工人,想刷哪面墙就刷哪面,整个虚拟世界可以实时交互,且看起来十分合理。

谷歌表示,这是想象力空间的无限释放,无论是自然世界或现实场景,还是构建动画、小说中的奇幻世界,甚至是突破时间与空间限制的未来世界,都可以被创造出来。

不少网友迅速上手,开始“放飞自我”式创作,其中,各类游戏风格世界不断涌现。

比如在沙滩上骑摩托:

更绝的是直接制作山寨版“任天堂”游戏。比如马里奥系列,《塞尔达传说》,《银河战士》。

即便抛开体验层面的不足不谈,Project Genie 在生成世界的质量与完成度上,依然足以令人震撼。这也难免让人产生进一步的联想,游戏从业者会不会大规模失业?

这一担忧并非空穴来风。根据 Informa 本周发布的游戏开发者大会(GDC)报告,33% 的美国受访游戏开发者、以及 28% 的全球受访游戏开发者表示,他们在过去两年中至少经历过一次裁员。Project Genie 可能会进一步扩大这种趋势。

不过,围绕 Project Genie 的能力边界,也有人提出质疑。

The Verge 的记者亲自上手试验后认为,从“游戏”的角度来看,Project Genie 所生成的“可玩世界”显得相当单调。

除了基础移动操作外,玩家几乎无事可做。没有任务目标,也缺乏音效反馈。更糟糕的是,输入延迟时有发生,甚至会出现角色失控、只能旋转视角的情况,严重影响整体体验的流畅度。

该记者还提到,在仅有 60 秒 的探索时间内,世界的一致性并不稳定。系统有时会“忘记”此前生成的内容,例如滚动的小球留下的颜料痕迹会突然消失,已生成的道路也可能被重新覆盖为草地。这些现象让人难以确认模型是否能够持续、可靠地维护同一个世界状态。

在内容生成层面,Project Genie 对知名游戏 IP 也存在明显限制。测试中,索拉、唐老鸭、高飞、杰克·斯凯灵顿等角色均无法直接用于生成可交互世界,相关内容在进入实际体验阶段会被系统拦截。

目前,与生成世界交互的智能体只能执行较为有限的操作,同一世界中多个模型之间也难以协同互动。此外,Genie 在渲染清晰文本、还原现实世界具体地点方面仍存在困难,智能体对控制指令的响应有时也会出现异常延迟。

对此,谷歌方面回应称,Genie 并非游戏引擎,团队更关注它在增强创意过程、提升构思能力以及加快原型制作方面所展现出的潜力。

在 Geinie 3 官网上也特别强调,目前产品仍处于早期研究阶段,因此会有:生成的世界可能看起来并不完全逼真,也不一定总是严格遵循提示、图像或现实世界的物理规律;角色有时可能难以控制,或者控制延迟较高;生成时间受限等问题。

在 Project Genie 上线不久,其背后的核心团队第一时间接受采访,包括 Google DeepMind 研究总监 Shlomi Fruchter、Google DeepMind 的研究科学家 Jack Parker-Holder、产品 Diego Rivas,他们都对世界模型长期关注,在这次访谈中深度揭秘 Project Genie 的关键问题。

这次对话讨论了:什么是世界模型?为什么只能生成 60 秒?Project Genie 的研发历程是什么?它未来真正可能改变的是哪些领域?

他们首先承认 Project Genie 的强大确实源于谷歌视频生成技术的积累,但同时他们也强调,Genie 并不是更强的“视频模型”,而是人类第一次可以实时走进、操控、改变的生成世界。

其中的核心差异是,世界模型是逐帧实时生成,能与过去保持物理与视觉一致性,并且用户可随时干预。这对延迟、内存、算力的要求,比普通视频生成高得多,也是更前沿、更有挑战的方向。

针对不少人抱怨“60 秒不够”的问题,他们表示这是在服务成本、系统稳定性和体验质量之间做出的权衡。他们其实已经做出过更长时间的生成世界,但在实际测试中发现,随着生成时间拉长,世界的动态感反而会逐渐减弱。

研究员表示“与其花两分钟体验一个世界,不如花一分钟体验两个不同的世界,体验感会更好。”

针对模型的生成速度,他们表示已经够快了,短期内进一步“加速”并没有太大意义。接下来,他们更重要的研发方向,是降低算力成本,让这种能力能够被更多人真正用得起。

在产品定位上,他们并不把 Genie 看作一款游戏,而更像是一个正在快速演化的实验场:

-

一方面,多人互动、长期一致性、复杂动态仍然是明确的技术瓶颈;

-

另一方面,娱乐、教育、具身智能、机器人训练等方向,已经展现出非常清晰的应用前景

回顾产品研发历程,从论文阶段的 Genie 1,到今天普通用户可以亲自上手体验的 Genie 3,这背后其实是谷歌一整套高度协同的跨部门合作。

谷歌实验室与谷歌创意实验室 是研发的核心力量,而服务团队、基础设施团队和沟通团队则共同兜底,确保这项起源于强化学习的前沿研究,能够被真实用户理解、体验并持续使用。

当团队回看去年八月时,他们很清楚,当时外界已经迫不及待想“走进这个世界”,但 Genie 仍然只是一个规模庞大的研究项目。即便如此,研发人员脑海中已经浮现出一系列潜在应用场景,其中最清晰的方向之一,正是具身智能。一个标志性的例子,是他们与 Simmer 项目的长期合作。

Simmer 是由双子座模型驱动的目标导向智能体,能够在 3D 世界中执行复杂任务。过去,它只能在少数几个固定游戏环境中训练;而现在,借助 Genie 3,只需一句文本指令,就能生成一个全新的、甚至是照片级写实的虚拟世界,把智能体直接“放进去”完成任务。

从 Nano Banana Pro 的图像创作,到谷歌视频生成的成熟,再到可交互的世界模型 Project Genie ,生成式技术正在构成一个连续体,世界模型将成为第三次技术跃迁。

以下是播客的更多细节,欢迎来看:

研究员:二者绝对是相关的,而且世界模型的研发难度其实更高。普通的视频模型,能在整个视频的时间线上自由调整过去和未来的帧,自由度很高 —— 就像有一块画布,模型能随时间生成视频,在画面的各个位置做微调,让整体效果连贯美观。

但 世界模型的难点在于,世界是持续演变的,每一帧的输入都是未知的,模型必须保证生成的画面既和过去的内容连贯,又能匹配用户当下的操作,所以技术难度会大很多。

其实开发 Genie 1 时,我们用的是 Imagine 模型,当时我们的模型效果并不好,而且想要生成合适的图像也非常困难。Nano Banana Pro 是在Genie 3之后推出的,技术进步的速度真的令人惊叹。 也许未来某一天,我们定义虚拟世界的方式,将不再局限于图像和文本,但就目前而言,这种方式已经给了用户足够的创作灵活性。

其实 Nano Banana Pro 就是个很好的例子,如果一张图片里有 10 个人脸,想要对这张图进行编辑,模型就容易出问题。所以我想知道,Genie 3 的自然性能边界在哪里?

研究员:这个模型肯定不是完美的,目前它还只是一个研究预览版本。我们希望让大家亲自体验,看看它的优势在哪里,不足又在哪里,我们也能从用户反馈中学习和优化。

目前模型在各类创意环境的视觉呈现上做得不错,画面可以非常精致,但在世界的动态表现上还有短板 —— 有时候初期的动态效果很好,但时间久了,动态感会逐渐减弱,这也是我们正在优化的点。 不过它的表现已经足够令人惊喜了,所以还是建议大家亲自上手试试,看看哪些玩法能达到理想效果。

研究员:不过说到延迟问题,还有很多技术点需要考虑。Genie 3 的研发有一个核心约束:我们希望实现特定操作频率下的实时低延迟,也就是说,用户操作的往返延迟要极低。同时,内存也是一个巨大的约束 —— 模型的上下文长度越长,通常算力成本就越高,运行速度也会越慢。

所以研发的核心挑战,就是平衡这些相互冲突的目标。而在研究层面,我们正在所有这些领域持续优化,我们相信,模型的性能会不断提升,变得更强大、更快、更经济,这也是行业的整体发展趋势。

研究员:其实我们已经做出过能连续生成更久的演示版本了,但我们觉得 60 秒是一个比较合适的时长 —— 既能让用户充分体验虚拟世界,又能保证为足够多的用户提供服务,这其实是在服务成本上做的权衡。

而且就像我们之前提到的,生成时间越长,世界的动态感会逐渐减弱。所以我们觉得,与其花两分钟体验一个世界,不如花一分钟体验两个不同的世界,体验感会更好。 当然,如果用户反馈希望延长时长,我们也会做出调整。

这也和虚拟世界的类型有关,比如如果你在体验高山速降滑雪,两分钟的时长会很过瘾,因为整个过程是持续的动态体验;但如果只是探索图书馆,两分钟可能就没那么有趣了。

研究员:在当前实时交互需求下,生成速度已经足够快,短期内进一步加速的意义不大。 因为模型是实时生成虚拟世界的,速度再快其实也没有意义了 —— 它的生成速度已经和用户的体验速度完全匹配。接下来我们的研发重点,会放在降低算力成本上,这样才能让更多人用上这款产品。 同时,在保持速度的前提下,不断增加新功能,这本身也是一个巨大的挑战,我们希望在各个方面都把模型做得更好。

研究员:首先,八月份发布模型和演示视频后,我们让一小部分人体验了产品,核心是为了收集反馈 —— 因为这是一款全新的应用,一种全新的体验,我们需要思考如何负责任地将它推向市场。

从那以后,我们的大部分工作都集中在基础设施、服务架构和成本控制上,毕竟我们希望能让尽可能多的用户体验到它。而美国的谷歌 Ultra 订阅体系,能让我们触达足够多的用户,收集到第一手的反馈:比如用户觉得哪些功能有用,会如何和产品互动,哪些玩法体验最好。这段时间里,我们也在持续完善可信测试项目。

这其实是模型开发周期中最核心的阶段,因为我们能从不同类型的用户身上学到很多东西,无论是创意工作者,还是教育领域的从业者,都能给我们带来丰富的洞察,让我们知道模型目前的实际应用价值、未来的发展方向,以及哪些体验是用户最期待的。

回头看八月份,当时我们知道大家肯定想体验这款产品,但它那时还只是一个大规模的研究项目。我们脑海里有很多应用场景,比如智能体、机器人这类具身智能领域,都能用到这项技术。去年年底还有一个和我们类似的项目发布,他们也用Genie 3来训练游戏智能体。

从消费端的角度来看,我们觉得这个产品会很有吸引力,所以想收集用户反馈,但当时也不确定是否已经到了面向更多用户发布的时机。而迭戈主导的可信测试项目,让我们发现,用户第一次上手这款产品时,都会有惊艳的体验。我们希望深入了解更多的应用场景,所以这次的发布,也是我们在这方面迈出的一大步。

一年前,我根本没想到这个模型能有这么强的吸引力,但现在它已经成为一款非常有趣的产品,我们也很期待大家会用它来做什么。

研究员:幕后参与的团队非常多 ,谷歌实验室、谷歌创意实验室是核心 —— 画廊里的那些虚拟世界,大多是创意实验室的作品;还有服务团队、基础设施团队,基本上有一个完整的幕后团队在推动这项工作。从八月份发布模型到现在,我们一直在全力冲刺,所有团队的付出都堪称英勇。

我们还和 沟通团队 深度合作,因为想要向大家解释一款全新的模型,一种大家从未体验过的技术,是一个非常细致的话题 —— 它起源于强化学习这个相对小众的领域,现在却被媒体、社交媒体上的各类人群广泛讨论,所以用正确的方式传递这项技术,非常重要。

回顾这个领域的研究起点,我们甚至不确定这项技术能否成功落地。而现在,我们让它实现了实时交互,达到了不错的画质,完成了从研究构想到发布模型,再到推出面向用户的体验产品的闭环,这一点让我非常兴奋。这并非理所当然,也充分体现了谷歌内部跨技术栈的团队协作能力,这种能力非常独特。

Jack:没错,我们一开始其实并不知道这个模型的具体应用场景。去年年底,Genie 团队还在做纯粹的研究项目,Genie 1最初只是一篇研究论文,和 VO(谷歌的视频生成模型)完全不同。

与此同时,我们还在做 Doom 游戏引擎的相关研究,这项研究充分展现了实时交互的潜力,但它仅适用于 Doom 这一个特定的游戏世界,迭戈可以再聊聊这一点。

另外,2024 年 12 月 VO(谷歌的视频生成模型)2 的发布,在 AI 领域已经是很久以前的事了,但当时我看到它的效果时就觉得,视频生成技术已经成熟了,视觉质量达到了行业前沿,值得我们深入探索。

于是我们达成共识,认为这项技术的潜力无限,随后组建了跨团队的研发小组,汇集了各个领域的专家 —— 他们都在不同的技术领域有积累,我们相信把这些技术结合起来,会产生不可思议的效果。而我们的研发,并非针对某个特定的下游应用场景,而是因为它蕴含着无数的应用可能。

最酷的是,我们脑海里有一些预想的应用场景,比如和 Simmer 项目的合作,我们和这个项目的合作已经有很长时间了,他们也参与了 Genie 2 的研发,体验过 Genie 2,现在已经基于 Genie 3 发布了相关产品。

Simmer 是我们最强大的目标导向智能体之一,能在 3D 世界中互动,是由双子座模型驱动的 —— 你可以在 3D 世界中向它输入文本指令,它就能完成各种不同的目标,泛化能力非常强,还能通过自我提升学习。 这也是我们迈向通用人工智能、具身智能的重要方向。

去年年底我们发布了这款智能体,他们就用 Genie 3 的虚拟世界来探索智能体的能力。要知道,Simmer 原本只在几款游戏中接受过训练,但现在借助 Genie 3,你只需输入文本,就能创建一个全新的、甚至是照片级写实的虚拟世界,然后把智能体放进去,看它完成各种任务。这两个项目的结合,可以说是水到渠成。

研究员:从应用层面来说,我个人对娱乐和教育领域的应用最期待。我们希望让更多人体验这款产品,看看凭借现有的技术,现在能打造出哪些应用。教育领域是我们重点关注的方向,比如让人们在虚拟世界里互动学习 —— 想象一下,能为用户打造一些他们在现实中无法体验的场景,比如一个孩子害怕蜘蛛,我们可以打造一个满是蜘蛛的房间,让孩子在虚拟世界里慢慢适应,克服恐惧。我的孩子就怕蜘蛛,所以我觉得这种个性化的全新体验,价值非常大,这也是我们近期的研发重点。

另一方面,我们之前也聊过,机器人技术和具身智能领域的世界模型,潜力也非常大。当然这个领域还有很多研究工作要做,但我个人对它充满期待。简单来说,核心思路就是:如果一个模型能模拟现实环境,那我们就可以用它在虚拟世界里训练机器人,或是让具身智能体在虚拟世界里学习,甚至实时辅助智能体做出决策。

Genie 计划虽然现在已经很惊艳了,但它只是一个起点。未来我们会和谷歌实验室继续深度合作,不断优化产品的功能、操控方式、应用架构等;也会拓展更多的使用场景,不局限于Genie 计划这一个应用,还会推出开发者 API,让更多开发者参与进来。

不得不说,开发者总能发掘出产品的商业价值,找到极具经济影响力的应用场景,这也是我觉得很有意思的一点 —— 除了娱乐,世界模型还能在哪些领域找到产品市场契合点。

而且很多功能在不同的应用场景中是相通的,比如更广泛的交互性。可以肯定的是,机器人技术的发展,不可能只靠方向键来实现,未来的机器人助手需要更多的操控方式,而这和虚拟世界的交互研发是相通的。

八月份发布 Genie 3,让我们成为首批推出这类模型的团队,也让我们能和谷歌内部的各个团队展开合作。我们会认真吸纳所有的用户反馈,把大家提出的建议都列出来,成为下一代模型的研发方向。我之前跟杰克说过,我们只实现了目标的 50%—— 因为我们总是会设定极具野心的目标,这个领域还有太多可以探索的地方,模型还有很多不足,需要我们不断优化。

这个领域的发展空间巨大,我们才刚刚起步。就像写论文一样,一个项目完成后,你马上就会想,下一个项目可以加入哪些功能,做得更好。

现在社区里也出现了很多有趣的世界模型,有些和 Genie 3 很相似,但我们的目光已经放得更远了。

研究员:我建议大家尝试个性化创作,打造属于自己的、其他系统无法实现的世界。当然,用它打造游戏环境也很有趣,但这类场景其他系统也能做到;而把现实中的专属事物 —— 比如一个玩具、一张照片,或是让自己以特定风格出现在真实的环境中,这种体验是独一无二的。

这让我想起了 VO(谷歌的视频生成模型)早期的一个研究项目:有人用 VO(谷歌的视频生成模型)为阿尔茨海默病患者重现童年记忆,让他们在虚拟世界里重温过去,这个项目特别棒。所以我觉得,把个人专属的事物融入虚拟世界,让它们 “活” 过来,这种互动方式非常有价值,大家可以试试这个方向。

另外,大家肯定会发现,模型的提示词创作目前还不够完善,但这恰恰是机会。几年后当这个模型变得非常成熟时,大家会想起现在这个阶段,就像我们现在看待 VO(谷歌的视频生成模型)3 一样 —— 现在 VO(谷歌的视频生成模型)3 的每个提示词都能生成优质视频,精灵 3 号的每个提示词基本也能实现预期效果,但在早期,提示词的创作至关重要,甚至有人会花 10 到 20 分钟精心打磨一个提示词。

所以如果第一次创作的效果不好,别放弃,这款全新的模型,可能会以你意想不到的方式呈现出惊喜的效果。而且亲自上手体验,你就不是在消费一款产品,而是在探索前沿技术。

研究员:还有一个玩法也很有趣,你可以在虚拟世界里设置挑战,把这个世界分享给别人,让对方完成任务, 比如从 A 点走到 B 点。这是一种基础的、有目标的游戏体验,现在的模型已经能实现了。比如那个球的场景,你可以让别人用球写出自己的名字,这类简单的挑战都能设置。

就像杰克说的,现在的体验虽然还比较基础,但它蕴含着巨大的创意潜力。比如还有一个带环的场景,你可以操控角色穿越环道,体验飞行的感觉,这也是用户发掘的玩法。

人们还经常问,行业的前沿在哪里,我们下一步要做什么。我经常会做一件事:长时间沉浸在 Genie 3 的第一人称写实世界里,然后看向窗外,对比虚拟和现实的差距。我认为最终,虚拟世界会和现实世界变得几乎无法区分,虽然今天我们不深入聊这个话题,但从模型的性能发展来看,这显然还有很长的路要走。但如果能生成和现实高度逼真的世界,在里面自由移动、互动、完成各种事情,那该多不可思议。

而这也是驱动我们开展这项研究的核心愿景:想象你拥有一个宇宙的副本,你可以在其中随心所欲。显然,这个副本有巨大的应用价值,能用到很多领域。这虽然是一个非常远大、甚至可能无法实现的目标,但它就像北极星一样,一直指引着我们。

比如我们这次把恐龙鲍勃放进虚拟世界,其实就是在重构现实空间,给现实事物做有趣的增强。未来这方面的探索,一定会非常有意思。

研究员:这其实取决于你如何定义世界模型。如果是指交互式的视听体验类世界模型,我认为今年、明年,就会有越来越多的人接触到它, 我们也会看到它在一些领域大放异彩,最终成为很多应用的基础功能。

但就像现在的视频生成技术,虽然发展很快,但真正融入普通人日常生活的比例其实并不高,世界模型也需要时间来完成用户普及,找到合适的应用场景 —— 毕竟视频和图像不同,世界模型又和视频生成不同。

而如果是具身智能领域的世界模型应用,很难给出具体的时间线,但这个领域已经在取得不错的进展了。

另外,用户的人群特征也很重要:有些经常接触交互式媒体的人,会成为世界模型的早期使用者,他们知道该如何体验; 但如果把它交给一个对前沿技术不感兴趣的家人,他们可能会觉得无从下手,体验不到产品的魅力。

但具身智能相关的应用,可能在未来 1-2 年就会走进现实,普通人会在生活中直接接触到, 所以最终的普及时间,还是取决于用户所处的技术接受曲线位置。

还有一点,Genie计划也印证了一个趋势:生成式技术正在形成一个连续体,从 Nano Banana Pro 的图像创作,到 VO(谷歌的视频生成模型)的视频生成,再到现在Genie 3的交互式实时媒体创作,成为第三个核心支柱。 我们希望未来有更多人能体验到这个连续体上的各类创作体验。

研究员:世界模型的发展,和图像、视频生成还有些不同。图像和视频生成的作品,能被数百万人观看,一个人的创作可以被广泛传播,家人、朋友都能看到;而世界模型的独特之处在于,你可以在探索的过程中,不断改变周围的世界,这开辟了很多我们未曾考虑过的新途径、新玩法。

图像和视频生成,本质上是用新技术替代或自动化了过去的一些创作方式,当然也带来了新的能力和限制;但世界模型,实现了很多过去根本不可能做到的事情,这是它最大的不同,当然二者也有很多相似之处。

还有一个我们非常兴奋的想法,大家在演示中也能看到端倪:用户可以在现有虚拟世界的基础上继续创作,这样就会形成很多有趣的世界分支,还能追溯创作源头。 这方面的潜力非常大,值得我们深入探索。

Genie 计划上线时,用户可以下载自己的虚拟世界演示视频;未来我们还会探索更多的世界分享方式,让大家能以更有趣的方式在别人的世界基础上创作。

从世界模型的发展来看,技术进步的节奏是怎样的?显然我们已经看到了巨大的进步,图像生成、VO(谷歌的视频生成模型)视频生成、核心双子座模型,都取得了长足的发展。世界模型是不是也在遵循同样的发展轨迹,到处都是触手可及的技术突破,同时受益于算力规模和推理能力的提升?

研究员:可以这么说。图像生成技术显然比视频生成更成熟,视频生成和世界模型之间的差距,我无法准确衡量,但可以肯定的是,世界模型是超越视频生成的前沿技术。

最新一代的视频生成模型,画质已经比Genie 3高很多了,我们也不指望Genie 3现在能生成极致精美的视频,因为实时交互的约束,是普通视频生成模型所没有的。 所以世界模型的发展,可能会比视频生成稍慢一些,但它能带来全新的体验。

说实话,我们现在仍处于技术快速进步的阶段。硬件始终是一个巨大的约束,这对所有模型来说都是如此。行业的整体趋势是,在成本基本不变的情况下,让模型的运行效率越来越高。但最终,我们还是需要更易获取的硬件支持 —— 比如希望未来人们能直接在自己的设备上运行这类模型,实现无延迟的即时体验。

目前高性能的 TPU、GPU 还并非人人可得,硬件的发展速度因为一些实际原因,会比模型研发慢一些,但这也是我们的未来方向 —— 希望到 Genie 5 时,大家能在手机上运行完整的通用模拟系统。

这一点我们也讨论过,谷歌拥有垂直技术栈的优势,这也是我们在谷歌、在深度思维工作的魅力所在:我们既能站在模型研发的前沿,又能利用谷歌最好的硬件来支持模型的运行。而且专门为世界模拟打造的硬件,本身也极具发展潜力,它就像通往另一个维度的入口,点击就能进入,充满了新鲜感。

传送门:

https://labs.google/projectgenie

链接:

https://blog.google/innovation-and-ai/models-and-research/google-deepmind/project-genie/

https://deepmind.google/models/genie/

https://www.youtube.com/watch?v=Ow0W3WlJxRY&t=4s

https://www.theverge.com/news/869726/google-ai-project-genie-3-world-model-hands-on?view_token=eyJhbGciOiJIUzI1NiJ9.eyJpZCI6ImZCakl0bmxFNGwiLCJwIjoiL25ld3MvODY5NzI2L2dvb2dsZS1haS1wcm9qZWN0LWdlbmllLTMtd29ybGQtbW9kZWwtaGFuZHMtb24iLCJleHAiOjE3NzAxNDAwNTYsImlhdCI6MTc2OTcwODA1OH0.q5OBTD_V36-65oc1EGqPxKYCZF00c7ODvifvagVcwbA&utm_medium=gift-link

声明:本文为 AI 前线整理,不代表平台观点,未经许可禁止转载。

InfoQ 2026 全年会议规划已上线!从 AI Infra 到 Agentic AI,从 AI 工程化到产业落地,从技术前沿到行业应用,全面覆盖 AI 与软件开发核心赛道!集结全球技术先锋,拆解真实生产案例、深挖技术与产业落地痛点,探索前沿领域、聚焦产业赋能,获取实战落地方案与前瞻产业洞察,高效实现技术价值转化。把握行业变革关键节点,抢占 2026 智能升级发展先机!

今日荐文

被Anthropic强制改名!Clawdbot 创始人一人开发、100% AI 写代码,腾讯又跟上了热度

Altman承认“搞砸了”!曝 GPT-5.2 牺牲写作换顶级编程,明年成本降 100 倍,实锤Agent 已能永久干活

奥特曼小号泄密:OpenAI代码工作100%交给Codex!工程师才揭底Codex“大脑”运行逻辑,碾压Claude架构?

慕了!内存芯片巨头年终奖人均64万;32岁程序员猝死背后公司被扒,曾给39万“封口费”;马斯克曝星舰成本将降99%,商业航天受捧|AI周报

硅谷“钱太多”毁了AI ?!前OpenAI o1负责人炮轰:别吹谷歌,Q-Star 被炒成肥皂剧,7年高压被“逼疯”!

你也「在看」吗?👇

<原文链接:https://mp.weixin.qq.com/s/Ke4s_vXTc4eRXkMMtr78kQ

暂无评论内容