![图片[1]-今夜无显卡!老黄引爆Rubin时代,6颗芯狂飙5倍算力-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260107073219155-1767742339-55306e0f0b3cd1a1416d17819eb07c63.jpeg)

新智元报道

【新智元导读】刚刚的CES 2026上,老黄带着Vera Rubin超算架构向全世界走来!Rubin的推理性能比Blackwell提升了5倍,训练性能提升3.5倍,成本降低10倍,已经大规模投产,将于2026下半年面世。没有新显卡的昨夜,老黄表示all in AI!

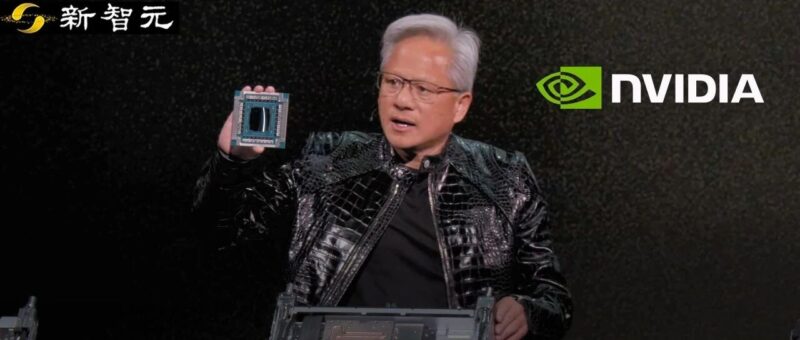

天空一声巨响,全新版本的「皮衣老黄」闪亮登场。

![图片[2]-今夜无显卡!老黄引爆Rubin时代,6颗芯狂飙5倍算力-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260107073220787-1767742340-f95a2154643fab2fbcabaafa52bb7cb3.gif)

在本次CES演讲中最为激动人心的瞬间,就是英伟达全新一代芯片架构——Vera Rubin正式登场!

全球AI算力告急?老黄霸气回应:Vera Rubin已全面投产。

这是新一代的算力怪兽,也是对上一代霸主Blackwell的降维打击——

推理Token成本直接暴降10倍,算力性能狂飙5倍。

就连训练MoE模型所需的GPU数量,也直接减少了4倍。

曾经,Blackwell终结了Hopper;如今,Rubin亲手埋葬了Blackwell。

![图片[3]-今夜无显卡!老黄引爆Rubin时代,6颗芯狂飙5倍算力-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260107073223138-1767742343-91ac6f6569d5e9f3deb97b4b81442ff9-scaled.png)

全程近两小时演讲,老黄提及重点包括——

下一代Rubin平台亮相:六颗芯片,推理狂飙十倍

自动驾驶端到端模型:AlphaMayo会思考、自主推理,全程0接管上路

物理AI全家桶开源:基础模型、框架

![图片[4]-今夜无显卡!老黄引爆Rubin时代,6颗芯狂飙5倍算力-AI Express News](https://www.aiexpress.news/wp-content/uploads/2025/05/1748005946-e42712f61a4e6b0adba95f6bacb450c6.png)

至于游戏玩家?

对不起,这次真的没有新显卡。

![图片[5]-今夜无显卡!老黄引爆Rubin时代,6颗芯狂飙5倍算力-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260107073228927-1767742348-38ba027b039dc748e45704e1c0632124.png)

英伟达在X上的一纸公告,彻底击碎了「攒机党」最后的幻想:CES 2026将没有任何新GPU发布。

这意味着,英伟达自2021年以来连续五年在CES发布新硬件的传统,就此终结。

传闻已久的RTX 50 Super系列,受困于GDDR7显存的「产能地狱」,大概率已经胎死腹中。

![图片[6]-今夜无显卡!老黄引爆Rubin时代,6颗芯狂飙5倍算力-AI Express News](https://www.aiexpress.news/wp-content/uploads/2025/05/1748005937-e247941b79065a0391afc9648900dec5.png)

去年10月,老黄曾预计:未来五年,将有3到4万亿美元砸向AI基础设施。

Vera Rubin的大规模投产,可谓生逢其时。

如果说Blackwell打破了单卡性能的极限,那么Rubin解决的则是系统规模化的难题。

从此,算力将像电力一样廉价,AI的大爆发已近在咫尺!

![图片[7]-今夜无显卡!老黄引爆Rubin时代,6颗芯狂飙5倍算力-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260107073230886-1767742350-58c85223848b52f408eb7294ba49894b-scaled.png)

2024年,Vera Rubin架构首次亮相。

等了两年,现在它终于正式投产了!

Blackwell架构,从此将退出历史舞台。

演讲现场,老黄告诉大家:AI所需的计算量急剧飙升,怎么办?不用怕,Vera Rubin,将解决我们面临的根本性挑战!

这套为万亿参数模型的海量推理而生的平台,会彻底让算力低成本、规模化、工业化生产。

Rubin架构,以天文学家Vera Florence Cooper Rubin而命名。

![图片[8]-今夜无显卡!老黄引爆Rubin时代,6颗芯狂飙5倍算力-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260107073234735-1767742354-65f23851449654eb4c7c09b4f418731d-scaled.png)

可以说,Rubin是英伟达第一次把CPU、GPU、网络、存储、安全,当成一个整体来设计。

核心思路就是:不再「堆卡」,而是把整个数据中心变成一台AI超算。

整个Rubin平台,由这6个关键组件构成。

![图片[9]-今夜无显卡!老黄引爆Rubin时代,6颗芯狂飙5倍算力-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260107073236698-1767742356-cd1995d9fd4b1571c715c2c395aee891.png)

![图片[10]-今夜无显卡!老黄引爆Rubin时代,6颗芯狂飙5倍算力-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260107073238212-1767742358-ea4abc7e684300bc2e6969b540fe05dc.gif)

其中,Rubin GPU是整个平台的核心。它搭载第三代Transformer引擎,为AI推理提供50 PFLOPS的NVFP4算力。

之所以能达到Blackwell GPU性能的5倍,是因为它的NVFP4张量核心,后者能分析Transformer各层的计算特性,动态调整数据精度与计算路径。

![图片[11]-今夜无显卡!老黄引爆Rubin时代,6颗芯狂飙5倍算力-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260107073239544-1767742359-ef449596bf4dc68cfa99e8a0153e248a-scaled.png)

另外,该架构还引入一颗全新的Vera CPU,专为智能体推理而设计。

它采用88个英伟达自研Olympus核心,完全兼容Armv9.2,并具备超快的NVLink-C2C 连接,能实现176个线程的全性能执行,I/O带宽和能效比直接翻倍。

![图片[12]-今夜无显卡!老黄引爆Rubin时代,6颗芯狂飙5倍算力-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260107073244502-1767742364-05a7a40ed9bf289a9988941c5d89e057-scaled.png)

当我们在Agentic AI或长期任务中启用全新的工作流时,会对KV cache造成很大压力。

为了解决存储和互联的瓶颈,Rubin架构特别改进了Bluefield和NVLink系统。它通过外部方式和计算设备相连,这样就能更高效地扩展整体存储池的规模。

BlueField-4 DPU是一个数据处理单元,它能卸载网络、存储和安全任务,还能管理AI的上下文记忆系统。

![图片[13]-今夜无显卡!老黄引爆Rubin时代,6颗芯狂飙5倍算力-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260107073248865-1767742368-5ec0ee30f705482a4aeb5c89deacec31-scaled.png)

NVLink 6中,单芯片就能提供每秒400Gb的交换能力。每块GPU提供3.6TB/s 的带宽,而Rubin NVL72机架提供260TB/s,带宽超过整个互联网。

通过3.6 TB/s的带宽和网络内计算能力,它能让Rubin中的72个GPU像一个超级GPU一样协同工作,直接把推理成本打至1/7。

![图片[14]-今夜无显卡!老黄引爆Rubin时代,6颗芯狂飙5倍算力-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260107073251233-1767742371-a1000d0a37fd09baeafb6573afe7d2bd-scaled.png)

现场,老黄给我们展示了Vera Rubin的托盘。小小的托盘上集成了2颗Vera CPU、4颗Rubin GPU、1颗BlueField-4 DPU和8颗ConnectX-9网卡,整个计算单元算力达到100 PetaFLOPS。

![图片[15]-今夜无显卡!老黄引爆Rubin时代,6颗芯狂飙5倍算力-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260107073256203-1767742376-2c1fa32ba10de54abecaf1afcd918070-scaled.png)

![图片[16]-今夜无显卡!老黄引爆Rubin时代,6颗芯狂飙5倍算力-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260107073259152-1767742379-375ae556f6011c357dde36e246686820.png)

Rubin的目标,是解决MoE和万亿参数模型的训练成本,它做到了吗?显然,成果是显著的。

训练、推理效率暴增

测试结果显示,Rubin架构训练模型时的运行速度,直接达到上一代Blackwell架构的3.5倍(35 petaflops),推理任务的速度则高达5倍,最高可达50 petaflops!

同时,它的HBM4内存带宽提升至22 TB/s,达到2.8倍,单GPU的NVLink互连带宽则翻倍到3.6 TB/s。

![图片[17]-今夜无显卡!老黄引爆Rubin时代,6颗芯狂飙5倍算力-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260107073300582-1767742380-04f7ea8a63a4a95c96d2e8bc1ddc6eac.png)

在超大规模MoE训练中,Rubin所需的GPU数量相比Blackwell可减少至1/4,同时整体能耗显著下降。

这背后,就有三大功臣。

NVLink 6,让GPU间互联带宽再次大幅提升,多卡训练不再被通信拖慢;Vera CPU与Rubin GPU的协同调度,可以减少「GPU等数据」的空转时间;而ConnectX-9与Spectrum-6的深度协同,也让大模型训练不会再被集群规模限制。

![图片[18]-今夜无显卡!老黄引爆Rubin时代,6颗芯狂飙5倍算力-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260107073302439-1767742382-c81f6c1ed127b7dbdd3be6411fcc3fa1-scaled.png)

![图片[19]-今夜无显卡!老黄引爆Rubin时代,6颗芯狂飙5倍算力-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260107073306173-1767742386-598f7880bd49fdbe83299241c1e642a4-scaled.png)

从此,训练万亿模型,不再是「堆钱」,只会是工程问题。

训练解决了,那推理呢?

结果显示,在推理侧,Rubin平台单位token的推理效率提升最高可达10倍!同样的模型和响应延迟,算力成本可以直接下降到原来的1/10。

所以,模型可以跑得起百万token的长下文,企业级AI应用也可以部署了。

![图片[20]-今夜无显卡!老黄引爆Rubin时代,6颗芯狂飙5倍算力-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260107073311336-1767742391-3f0ce489481b37cda0a463f78709acd3-scaled.png)

![图片[21]-今夜无显卡!老黄引爆Rubin时代,6颗芯狂飙5倍算力-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260107073314247-1767742394-f819887fc6cfe480c8e942d3cfe645ce-scaled.png)

存储瓶颈解决

如上文所言,让AI模型多跑一会的关键挑战,就在于上下文数据。

![图片[22]-今夜无显卡!老黄引爆Rubin时代,6颗芯狂飙5倍算力-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260107073317380-1767742397-edf10935c619f265113fdef03cc9a6d4-scaled.png)

大量KV Cache该如何处理?英伟达推出了由BlueField-4驱动的推理上下文内存存储平台。

这个平台在GPU内存和传统存储之间创建了「第三层」,直接让每秒处理的 token数提升高达5倍。

![图片[23]-今夜无显卡!老黄引爆Rubin时代,6颗芯狂飙5倍算力-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260107073320170-1767742400-6c020689d22cddea7407572ca6e9d9ee-scaled.png)

DGX Super POD

本次CES上,英伟达还推出了新一代DGX SuperPOD。

![图片[24]-今夜无显卡!老黄引爆Rubin时代,6颗芯狂飙5倍算力-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260107073322720-1767742402-a608f0413d2d7cbf3995acdc1ca6a191-scaled.png)

它把多个装有72个GPU的Rubin NVL72连接起来,形成了更大的AI计算集群。

在这次的DGX SuperPOD中,共有8个Rubin NVL72机架,相当于有576个GPU。

![图片[25]-今夜无显卡!老黄引爆Rubin时代,6颗芯狂飙5倍算力-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260107073300582-1767742380-04f7ea8a63a4a95c96d2e8bc1ddc6eac.png)

NVIDIA Vera Rubin NVL72 提供统一、安全的系统,集成了72 块Rubin GPU、36块Vera CPU、NVLink 6、ConnectX-9 SuperNICs和BlueField-4 DPUs

这样,SuperPOD就可以处理数千个Agentic AI智能体,以及数百万token上下文。

可以说,英伟达一次性解决了数百个GPU相连、管理存储的问题,直接给我们提供了开箱即用的AI基础设施。

![图片[26]-今夜无显卡!老黄引爆Rubin时代,6颗芯狂飙5倍算力-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260107073326995-1767742406-9f259da83d8c40e483250e22c9b625f6-scaled.png)

![图片[27]-今夜无显卡!老黄引爆Rubin时代,6颗芯狂飙5倍算力-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260107073330331-1767742410-69c80fb3b8c14e2fb99e603322991de3.png)

第三代机密计算平台

更为重要的是,Rubin是首个支持第三代机密计算(Confidential Computing)的AI超算平台。

模型参数、推理数据、用户请求都会被全链路加密,即使的云厂商,也无法直接访问明文数据。

这就解决了「敢不敢把核心AI放到云上」的问题,对于金融、医疗、政府、企业私有模型都非常重要。

这些大厂,第一批用上Rubin

老黄介绍说,Rubin会由AWS、Microsoft Azure、Google Cloud、Meta、OpenAI这些头部厂商先部署。

而到2026年下半年,Rubin平台就会进入大规模商用阶段。

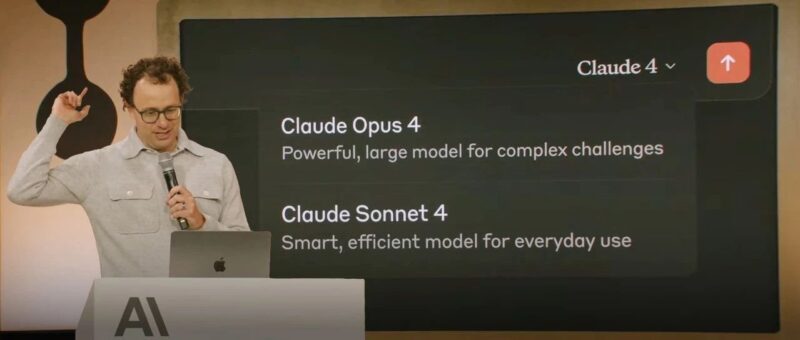

所以,下一代GPT、Gemini、Claude模型,大概率都会运行在Rubin架构上。

![图片[28]-今夜无显卡!老黄引爆Rubin时代,6颗芯狂飙5倍算力-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260107073331799-1767742411-1e4843995566e638cb87018b779e639c.gif)

![图片[6]-今夜无显卡!老黄引爆Rubin时代,6颗芯狂飙5倍算力-AI Express News](https://www.aiexpress.news/wp-content/uploads/2025/05/1748005937-e247941b79065a0391afc9648900dec5.png)

如何教会AI物理学的基础事实?

英伟达给出的答案是,把算力变成高质量的数据(Compute is Data)。

在这一体系中,「世界基础模型」Cosmos扮演着重要的角色。

交通模拟器输出的信号,被送入Cosmos再生成合理、运动上连贯的环绕视频,让AI学习其中真实世界的行为模式。

![图片[30]-今夜无显卡!老黄引爆Rubin时代,6颗芯狂飙5倍算力-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260107073333117-1767742413-90b0015aa3ccedc9b1719054d1694a37.gif)

如今,Cosmos已被全球下载数百万次,成为物理AI时代的重要基础设施。在英伟达,内部也在用其做自动驾驶研究。

在此基础上,今天,英伟达正式发布了「端到端」自动驾驶AI——AlphaMayo。

它是一个会思考、会推理的自动驾驶AI。从摄像头输入到车辆执行动作,全流程由模型完成。

![图片[31]-今夜无显卡!老黄引爆Rubin时代,6颗芯狂飙5倍算力-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260107073336972-1767742416-8e8bb2013ac0f62ead540b5c0fdeb475-scaled.png)

AlphaMayo独特之处,在于它具备了显式推理能力。

系统不仅执行转向、制动、加速动作,还会给出即将采取行动的理由,以及对应的形式轨迹。

![图片[32]-今夜无显卡!老黄引爆Rubin时代,6颗芯狂飙5倍算力-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260107073341290-1767742421-12fefb6e3729a6ab8355e30802f16b06.gif)

自动驾驶最大挑战,来自于「长尾场景」,几乎不可能覆盖所有国家、所有道路的数据。

AlphaMayo的策略是将复杂场景,拆解为多个熟悉的物理与交通子问题,通过推理将罕见情况分解为常见组合,完成应对。

在演示中,车辆可以在全程0接管状态下,完成路径规划与行驶,顺利抵达目的地。

![图片[33]-今夜无显卡!老黄引爆Rubin时代,6颗芯狂飙5倍算力-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260107073343658-1767742423-450c800d1aa55c263bc0539b8b87a52a.gif)

在自动驾驶领域,英伟达投入持续了八年,如今第一次把AI「五层架构」完整跑通。

由下到上:实体本身、芯片体系、模型层、基础设施层、应用层,构成了一套完全贯通的AI系统栈。

AlphaMayo构成模型层,梅赛德斯-奔驰汽车构成应用层。

这一次,老黄还官宣了,NVIDIA DRIVE AV软件首次搭载全新梅赛德斯-奔驰 CLA,提供L2级端到端驾驶。

![图片[34]-今夜无显卡!老黄引爆Rubin时代,6颗芯狂飙5倍算力-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260107073345238-1767742425-1325d4150a39455d137921192a674a17-scaled.png)

更重磅的是,Alpamayo家族全部开源。这一整套方法论,并不只适用于汽车,同样适用于机器人、机械臂等各类系统。

![图片[6]-今夜无显卡!老黄引爆Rubin时代,6颗芯狂飙5倍算力-AI Express News](https://www.aiexpress.news/wp-content/uploads/2025/05/1748005937-e247941b79065a0391afc9648900dec5.png)

下一阶段,机器人将以各种形态进入现实世界,前提是,它们首先在Omniverse中学会如何行动。

现场,老黄又召唤来了机器人瓦力登台配合演出,这里他讲了一句意味深长的话:

未来的系统,都诞生在计算机里。

![图片[36]-今夜无显卡!老黄引爆Rubin时代,6颗芯狂飙5倍算力-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260107073348468-1767742428-3ac046376e92c6aa811a8fc891419a4b.gif)

英伟达正把自身能力嵌入到,计算密度最高、最复杂的工业体系统,就像此前与Palantir、ServiceNow的集成一样。

如今,这一模式正被复制到了工业仿真与设计领域。

在具身智能领域,老黄直接扔下了一套针对物理AI(Physical AI)的「开源全家桶」——模型、框架及基础设施,应有尽有。

机器人的ChatGPT时刻已经到来!

![图片[37]-今夜无显卡!老黄引爆Rubin时代,6颗芯狂飙5倍算力-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260107073351570-1767742431-ba6f15a562a1bfd6890944d04c5a3de5-scaled.png)

目前,所有新模型均已上线Hugging Face,拿来即用:

NVIDIA Cosmos Transfer/Predict 2.5,这是完全可定制的世界模型,专门在虚拟世界里生成符合物理规律的数据,训练机器人的大脑。

NVIDIA Cosmos Reason 2,让机器像人一样「看懂」世界并进行逻辑推理。

NVIDIA Isaac GR00T N1.6,专为人形机器人打造,解锁全身控制,让机器人不再四肢僵硬。

为了解决机器人开发中「各自为战」的痛点,英伟达发布了两大神器:

Isaac Lab-Arena:这是GitHub上的开源框架,连接了主流基准测试,确保机器人在进厂打工前,已经在虚拟世界里经过了千锤百炼。

NVIDIA OSMO:无论是在工作站还是混合云,它都能统一调度数据生成、模型训练和测试,大幅缩短开发周期。

机器人技术已是Hugging Face上增长最快的领域。英伟达这次不仅是提供模型,更是深度集成:

LeRobot集成:Isaac和GR00T技术直接通过LeRobot框架即可调用。

硬件互通:Hugging Face的开源机器人Reachy 2和Reachy Mini现已完美适配英伟达的Jetson平台,语音、视觉、大模型能力瞬间拉满。

软件强还不够,硬件必须硬。如今,全新的Jetson T4000模组,直接将Blackwell架构带到了边缘端:

算力高达1200 FP4 TFLOPS,是上一代的4倍。

1000台起订单价仅1999美元。

70瓦功耗,简直是为能源受限的自主设备量身定做。

![图片[38]-今夜无显卡!老黄引爆Rubin时代,6颗芯狂飙5倍算力-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260107073359871-1767742439-73402a370dd3ec1e920bbdbd85e32d39.gif)

![图片[6]-今夜无显卡!老黄引爆Rubin时代,6颗芯狂飙5倍算力-AI Express News](https://www.aiexpress.news/wp-content/uploads/2025/05/1748005937-e247941b79065a0391afc9648900dec5.png)

每隔10-15年,计算产业就会重来一次。

演讲伊始,老黄还回顾了计算产业过去数十年的演进路径——

从大型机到CP,到互联网、云计算,再到移动计算,每一次平台级跃迁,都会催生一整套全新的应用生态,软件开发方式也随之重构。

而这一次,变化来得更加猛烈。

他提到,当前产业正同时经历两次平台级转变:一是从传统计算走向AI,另一个是整个软件、硬件栈的底层重塑。

AI正成为全新的「底座」,应用开始建立在AI之上。同时,软件开发与运行方式、应用生成方式发生了根本性变化。

这一切,共同推动了「加速计算+AI」对整个计算体系的重塑,五个层级正在同时被重新发明。

![图片[40]-今夜无显卡!老黄引爆Rubin时代,6颗芯狂飙5倍算力-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260107073401608-1767742441-31681cfb48ebb95715da05d9c30bf005-scaled.png)

2022年ChatGPT爆发后,AI才真正走进大众视野。一年之后,推理模型首次登场,引入了「测试时Scaling」这一概念。

模型不仅在训练阶段学习,还在推理阶段实时计算和推演。预训练、RL、推理这些阶段,都需要机器庞大的计算资源,也同时推动模型能力持续提升。

2024年,另一项突破开始显现,直到2025年,智能体系统(Agentic AI)才迅速扩散开来。

老黄再次提及,在英伟达内部,像Cursor这样的Agentic工具已深刻改变了软件的开发方式。

智能体AI之后,下一个前沿便是物理AI(Physical AI),理解自然规律和物理法则,为AI打开了全新疆域。

除此之外,过去一年,另一个具有决定性意义的变化来自「开源模型」。

DeepSeek R1的出现,作为首批开源推理模型之一,给行业带起来巨大震动。

但不可否认的是,其仍比前沿模型落后六个月。每隔半年,就有新模型涌现,而且越来越智能。

![图片[41]-今夜无显卡!老黄引爆Rubin时代,6颗芯狂飙5倍算力-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260107073404561-1767742444-19b78084ce1d439aa741ee53fd18f557-scaled.png)

![图片[42]-今夜无显卡!老黄引爆Rubin时代,6颗芯狂飙5倍算力-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260107073407733-1767742447-2189d4552184216ceb256144f1084825-scaled.png)

英伟达,正引领着开源模型的生态,遍布多个领域。而且,在多个榜单上取得了亮眼的成绩。

最具代表性的包括多模态Nemotron 3、世界模型Cosmos、机器人模型GR00T、蛋白预测模型OpenFold 3......

![图片[43]-今夜无显卡!老黄引爆Rubin时代,6颗芯狂飙5倍算力-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260107073411178-1767742451-e5e0daf9f2e74443fae84707f8b804d3-scaled.png)

![图片[44]-今夜无显卡!老黄引爆Rubin时代,6颗芯狂飙5倍算力-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260107073414979-1767742454-dfb1e1d9789b9dfba1a789e59b964aa8-scaled.png)

老黄现场表示,以上一切成果,都为构建AI智能体服务,这是真正突破性的发展领域。

当前AI模型已变得极其强大,智能体的推理能力为各类应用开启了大门。

![图片[45]-今夜无显卡!老黄引爆Rubin时代,6颗芯狂飙5倍算力-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260107073418776-1767742458-f737bea8dc0b1efd7de1dc8283f147ea-scaled.png)

令老黄深感震惊的是,首次在Perplexity见证了其同时调用多个模型——AI在推理任何环节,直接调用最顶尖的模型。

这背后本质上是「多云协同」,同时还具备了混合云特性。

老黄明确地表示,这就是未来AI应用的基本形态。或者说,因为未来应用都构建在AI之上,这就是未来应用的基础框架。

一方面,AI可以被深度定制。另一方面,系统始终保持最前沿。「定制+前沿」能力在同一架构中同时存在。

![图片[46]-今夜无显卡!老黄引爆Rubin时代,6颗芯狂飙5倍算力-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260107073422906-1767742462-ab569386f330cef05edc8529df7171bf.gif)

在软件世界之外,更大挑战来自于现实世界。为此,物理AI需要三台计算机——

第一台计算机:用于训练模型

第二台计算机:用于推理,运行咋i汽车、机器人、工厂等边缘环境

第三台计算机:专门用于仿真、模拟

老黄提到,仿真是整个体系的核心,只有在可控的数字环境中,AI才能反复尝试、评估行为后果,并逐步建立对世界的理解。

![图片[47]-今夜无显卡!老黄引爆Rubin时代,6颗芯狂飙5倍算力-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260107073424360-1767742464-e1986474f9a3c861ae3d43e48ee7f105-scaled.png)

![图片[6]-今夜无显卡!老黄引爆Rubin时代,6颗芯狂飙5倍算力-AI Express News](https://www.aiexpress.news/wp-content/uploads/2025/05/1748005937-e247941b79065a0391afc9648900dec5.png)

演讲最后还有一个幕后花絮,DGX Station台式AI超算将在2026年春季上线。

届时,英伟达还将同步推出更多针对GB300系统的实战手册(Playbooks)。

![图片[49]-今夜无显卡!老黄引爆Rubin时代,6颗芯狂飙5倍算力-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260107073428196-1767742468-901503504ff60cbca21447254f67a5be-scaled.png)

如果说DGX Spark是开发者的入门首选,那么DGX Station就是一台放在你办公桌上的微型数据中心:

搭载GB300 Grace Blackwell Ultra超级芯片。

配备高达775GB的FP4精度一致性内存(Coherent Memory)。

拥有Petaflop级AI算力,支持在本地运行高达1万亿(1T)参数的超大规模模型。

得益于强大的硬件基础,DGX Station实测威力惊人:

LLM预训练速度高达250,000 Token/秒。

支持对数百万数据点进行聚类和大型可视化。

从DeepSeek R1的开源震动,到Agentic AI的全面爆发,计算产业正在经历一场前所未有的重塑。

在这个只有玩家落泪的早上,一个由物理AI驱动的全新世界,正在Vera Rubin的轰鸣声中,加速向我们走来。

<原文链接:https://mp.weixin.qq.com/s/EprbrMBArltI_YUhNqrY5A

暂无评论内容