![图片[1]-MiniMax海螺首次开源VTP,Tokenizer才是视频生成Scaling的新主角-AI Express News](https://www.aiexpress.news/wp-content/uploads/2025/12/20251215190816763-1765796896-888b45711a1c482dccb564fa74d848be.gif)

今天,我们很高兴向大家介绍 MiniMax 视频团队刚刚开源的工作—— VTP(Visual Tokenizer Pre-training);这个工作讨论的是视觉生成模型中的关键组件—— tokenizer,对于整个生成系统的 scaling 性质。

这个说法可能会让大家感到有点陌生:什么时候 tokenizer 也有 scaling 性质了?

Scaling 作为大模型时代的核心纲领,其讨论的对象一般是围绕主模型(比如 DiT)的参数/算力/数据规模,tokenizer 则很少和 scaling 关联到一起。

而我们想要通过 VTP 展现的是,tokenizer 不仅对生成系统的 scaling 起着决定性的作用,实现这一点的核心方法也蕴含着简洁而深刻的思想。

一句话来说—— VTP 把 latents 易学性和通用表征学习建立起明确关联,从而第一次将 tokenizer 作为 scaling 的主角,展现出全面的 scaling 曲线和扩展方向。

VTP 提供了一个全新的视角,指导我们除了在主模型上投入更多参数/算力/数据之外,还可以通过 tokenizer 的 scaling 来提升整个生成系统的性能。

![图片[2]-MiniMax海螺首次开源VTP,Tokenizer才是视频生成Scaling的新主角-AI Express News](https://www.aiexpress.news/wp-content/uploads/2025/12/20251223000157757-1766419317-388217469321114f676ddcf949301d16.png)

与很多 tokenizer 工作不同的是,VTP 在设定上不对下游的主模型(DiT)训练过程做任何修改,仅通过前置优化 tokenizer 来实现端到端生成性能的倍数提升。

更为本质的是,我们给出的不是一个“单点解”(在大量限定条件下把某个指标刷到超出理论上限),而是一条随着 tokenizer 投入的参数/算力/数据规模持续提升的生成性能曲线。

这意味着我们尽可能去避免过拟合特定场景,追求一个在真实工业级环境中可以广泛生效的方法。

这里,我们想从一个更高的视角跟大家分享一下我们对这个问题的理解和思考。

![图片[3]-MiniMax海螺首次开源VTP,Tokenizer才是视频生成Scaling的新主角-AI Express News](https://www.aiexpress.news/wp-content/uploads/2025/12/20251208235641526-1765209401-fbfd139e91f52781a670bb6ed101f4c3-scaled.png)

Latent 的易学性

Tokenizer 将原始图像/视频转化为高度压缩的特征,一般称之为 latents。在我们早期的工作 VA-VAE 中,我们提出 latents 的一个新性质:易学性。

这背后,源自我们注意到不同的 latents 对于下游的生成建模来说有着截然不同的表现,那么最有利于下游生成的 latents 则成为我们追求的一个目标。

但易学性的优化是困难的,因为主流的生成系统例如 LDM(latent diffusion model)都是两阶段形态,先由 tokenizer 将原始分布转化成 latents,再由一个生成模型来建模这个 latents,这个过程无法端到端优化(我们也尝试过一些端到端思路,比较 tricky,这里就不展开了)。

因此我们寻求一个可以被优化的代理任务,并希望这个代理任务和易学性有较好的关联,这样我们就能间接优化易学性了。

这个思路下有不少代表性工作,例如 VA-VAE、EQ-VAE、SER 等等(最近开源的文生图模型 FLUX.2 也就这个问题展开了一个很深入的讨论,有兴趣可以看这个 blog)。

![图片[4]-MiniMax海螺首次开源VTP,Tokenizer才是视频生成Scaling的新主角-AI Express News](https://www.aiexpress.news/wp-content/uploads/2025/12/20251223000159860-1766419319-c397204927f30f823f0c0c347551bade.png)

![图片[5]-MiniMax海螺首次开源VTP,Tokenizer才是视频生成Scaling的新主角-AI Express News](https://www.aiexpress.news/wp-content/uploads/2025/12/20251223000200199-1766419320-9354525334e883517143e7be6fc0ffd1.png)

〓 FLUX.2 将我们提出的“易学性”作为一项重要的 VAE 评价指标

阅读链接:

https://bfl.ai/research/representation-comparison

![图片[6]-MiniMax海螺首次开源VTP,Tokenizer才是视频生成Scaling的新主角-AI Express News](https://www.aiexpress.news/wp-content/uploads/2025/12/20251221210234661-1766322154-a3638dc89981e54bfa22268c04c73f6d-scaled.png)

从易学性到通用表征学习

从 VA-VAE 提出易学性的概念之后,我们自己也尝试过很多方法,简单总结起来大概是它们都或多或少有一点用,但没那么本质。

事后来看也很合理,尝试将易学性等价为可精确计算的单一指标(例如频域分布、均匀性、scale 不变性、低秩效应等等)有些过于理想了,这些指标可能和易学性有一定关联,但远不是全部。

在持续思考这个问题的过程中,我们逐步意识到,这些方法都是在尝试让 latents 具备某些更高级的“结构”。

![图片[7]-MiniMax海螺首次开源VTP,Tokenizer才是视频生成Scaling的新主角-AI Express News](https://www.aiexpress.news/wp-content/uploads/2025/12/20251223000202390-1766419322-abd963e1873d2202ca990eb83de8fc03.png)

〓 在 VA-VAE 中,我们曾尝试将易学性对应到 latent 分布的“均匀性”

做一个思想实验:假如某种 latents 对于图像中的实体、位置关系具有高度结构化的表达,那么这种结构化表达对于下游 diffusion 建模来说也会更简洁、更容易,这些方面的生成效果也自然会更好。

那么什么是理想中的结构化表达?这让我们想到通用表征学习。我们无法精确定义一个完美的结构化表达,但我们可以说已有的通用表征学习方法对广泛的下游任务有良好的适用性。

例如,DINO 对各种 low-level、pixel-centric 的任务有非常好的通用性;CLIP 则对视觉-语义之间的跨模态理解任务有很好的 zero-shot 性能。

![图片[8]-MiniMax海螺首次开源VTP,Tokenizer才是视频生成Scaling的新主角-AI Express News](https://www.aiexpress.news/wp-content/uploads/2025/12/20251223000204899-1766419324-7e1653e7c844f89b92fdf2ca992dd713.png)

〓 人类视觉感知的图像是高度结构化的

这种对下游任务的广泛适用性,说明这类方法的 latents 具备高度结构化的表达,并且这里的结构化是面向人类感知的。过往的通用表征学习方法,是在持续优化人类视觉最关注的一些任务,这其实是一种非常好的性质。

我们甚至可以乐观的预期,如果基于这样高度结构化的 latents 来做生成,其在人类视觉感知所关注的方面上,会有很好的生成效果。人类的视觉感知实际上是一种极为高效且智能的压缩,这和理想 tokenizer 的第一性定义不谋而合。

![图片[9]-MiniMax海螺首次开源VTP,Tokenizer才是视频生成Scaling的新主角-AI Express News](https://www.aiexpress.news/wp-content/uploads/2025/12/20251215190821782-1765796901-6e53d0e2487a08c269915621d3add898-scaled.png)

Visual Tokenizer Pre-training

其实思考到这里,核心方案已经呼之欲出了,我们应该融合所有已知有效的表征学习方法来构建一个 tokenizer。

还剩下一些关键的技术细节需要解决,比如如何看待重建(在我们的视角下重建也是一种表征学习,只不过它比较低级)、ViT-based tokenizer 的实现细节、如何把多种表征学习方法实际有效的联合训练等等。

这里我们不展开细节,大家有兴趣直接看技术报告更高效一些。

![图片[10]-MiniMax海螺首次开源VTP,Tokenizer才是视频生成Scaling的新主角-AI Express News](https://www.aiexpress.news/wp-content/uploads/2025/12/20251223000205966-1766419325-00b94c754cdbb7b77263f893c1bf5ec6.png)

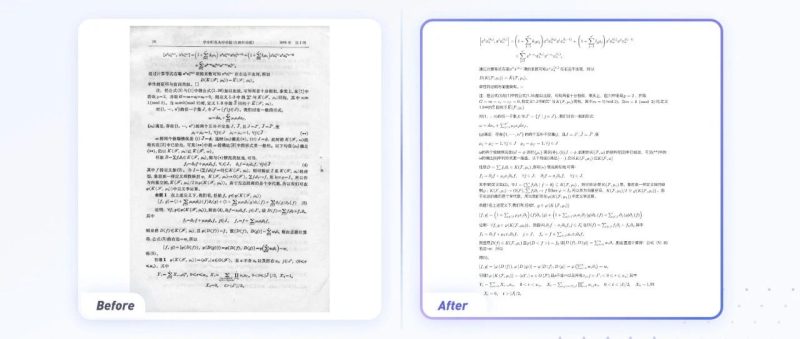

〓 VTP 预训练范式

这里再分享一些技术报告中没有的思考。为什么我们不像很多工作一样直接拿已有的模型来做 tokenizer,非要自己从头预训练一个呢?这里有两点核心的思考:

表征真的很重要,我们想要做到很极致。在我们的视角下表征包含了自监督、对比学习、甚至是重建(这些只是已知比较成熟的方法,实际上理想的表征远不止这些),市面上没有一个能够很好的融汇这些方法的模型,我们需要自己训练一个。

基于表征的 tokenizer 方案具备 scaling 的潜力,预训练是最合理的实现方式。如果直接利用已有模型蒸馏或者迁移,会因为 setting 过于复杂而破坏 scaling 的性质,也会受限于已有的模型规格而无法做充分的论证

第二点关于 scaling 是 VTP 最核心想要传达的观点。传统的基于纯重建的视觉 tokenizer 不具备 scaling,无论是参数/算力/数据规模,这一点在 Meta 的 ViTok 中有提及,我们的实验中也非常严格的论证了这一点。

ViTok 阅读链接:

https://arxiv.org/html/2501.09755v1

而对于 VTP 来说,我们把整个下游生成模型的训练和评估看作一个黑盒评估系统、把 tokenizer 作为 scaling 的主角,会惊喜的发现当我们用更大的参数量、投入更多的训练资源、利用更多的数据,下游的黑盒系统会有持续的提升。

考虑到这个黑盒评估包含了非常复杂的生成模型训练,能够在这样的黑盒评估下观测到 scaling,能一定程度说明这个结论的强度。

![图片[11]-MiniMax海螺首次开源VTP,Tokenizer才是视频生成Scaling的新主角-AI Express News](https://www.aiexpress.news/wp-content/uploads/2025/12/20251223000206137-1766419326-441d0633a56c81c372ed0c7cd24219c9.png)

〓 VTP 首次展示了 tokenizer 的 scaling

VTP 还有很多有趣的新视角。了解理解生成统一模型的读者应该能想到,VTP 天然适合理解生成统一模型的构建。tokenizer 层面的统一是更本质的统一,欢迎大家基于 VTP 做一些尝试。

数据分布也是 VTP 引出的很有潜力的方向,原理上 VTP 的训练数据分布会影响其表征的结构化方式,从而影响下游的生成表现;也就是说完全有可能通过优化 VTP 的训练数据分布来优化整个生成系统的效果,这在传统 tokenizer 上是很难实现的。

总而言之,tokenizer 作为生成系统中的重要组件,其拓展空间是非常广阔的,我们希望通过 VA-VAE、VTP 等系列工作,将一些不同的视角展现给大家,也期待业界内有新的方法和思想涌现。

论文和模型权重已经公开,更多细节欢迎大家阅读:

Codes:

https://github.com/MiniMax-AI/VTP

Paper:

https://arxiv.org/abs/2512.13687v1

原文链接:https://mp.weixin.qq.com/s/siMNgheRVNLeTSpiVQITYA

暂无评论内容