不是设计,而是进化。当交叉熵遇见 SGD,贝叶斯推理成了唯一的数学必然。

长期以来,LLM 的推理能力被视为一种难以解释的“涌现”。我们目睹了 Loss 的下降,却难以透视参数空间内部发生了什么。

近日,来自哥伦比亚大学和 Dream Sports 的研究团队发布了一组三部曲论文。

这项工作并未止步于实验观察,而是建立了一个连接优化目标 (Loss)、内部几何 (Geometry) 与推理功能 (Inference) 的完整物理图景。

它讲述了一个关于 LLM 如何运作的完整故事。其核心野心正如标题所言——试图用数学终结 Transformer 的黑盒时代。

他们证明了:Attention 机制并非某种近似的特征提取器,而是在梯度下降的驱动下,自发演化出的一套精确的贝叶斯推理机。

![图片[13]-优化即几何,几何即推理:用数学终结Transformer的黑盒时代-AI Express News](https://www.aiexpress.news/wp-content/uploads/2025/12/20251208235641526-1765209401-fbfd139e91f52781a670bb6ed101f4c3-scaled.png)

理论锚点:交叉熵的贝叶斯终局

Transformer 的训练通常基于最小化交叉熵损失。Paper I 首先澄清了这一优化过程的数学终局。

![图片[27]-优化即几何,几何即推理:用数学终结Transformer的黑盒时代-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260102194452734-1767354292-6b6d4aba19c1eb5d9f95f7e8d563a5aa.png)

论文标题:

The Bayesian Geometry of Transformer Attention

论文链接:

https://arxiv.org/abs/2512.22471

在无限数据与容量的极限下,最小化交叉熵 :

![图片[28]-优化即几何,几何即推理:用数学终结Transformer的黑盒时代-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260102194453957-1767354293-aae51f136a30e285f7b47db0654c06ed.png)

其最优解 在数学上严格等价于解析贝叶斯后验预测分布 (Bayesian Posterior Predictive Distribution):

![图片[29]-优化即几何,几何即推理:用数学终结Transformer的黑盒时代-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260102194453714-1767354293-aaed492c25f849c48125e774e5c80e75.png)

为了验证有限容量的 Transformer 是否真正逼近了这一极限,作者构建了贝叶斯风洞 (Bayesian Wind Tunnels) 。

这是一个完全受控的数学环境,其中每一步的解析后验都是精确已知的。

![图片[30]-优化即几何,几何即推理:用数学终结Transformer的黑盒时代-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260102194456496-1767354296-c247786d854200a5835254b746bd55fa.png)

实验结果表明,在双射学习与 HMM 状态追踪任务中,Transformer 展现了极高的精度。

![图片[31]-优化即几何,几何即推理:用数学终结Transformer的黑盒时代-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260102194456577-1767354296-1a6f16782acc8811edc8ffb5f4cbc0da.png)

更微观的证据来自单序列分析,这是证明模型真理解而非平均记忆的铁证:

![图片[32]-优化即几何,几何即推理:用数学终结Transformer的黑盒时代-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260102194458299-1767354298-5fbcbe019af195a1ccb887ade8ea5cc3.png)

而在 HMM 任务中,模型甚至展现出了完美的长度外推 (Length Generalization) 能力,证明其学会了通用的递归算法:

![图片[33]-优化即几何,几何即推理:用数学终结Transformer的黑盒时代-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260102194459318-1767354299-ed06f744301d9c002c6a6a186645c48c.png)

![图片[34]-优化即几何,几何即推理:用数学终结Transformer的黑盒时代-AI Express News](https://www.aiexpress.news/wp-content/uploads/2025/12/20251215190818681-1765796898-f6159061e56206da5ddc8ed1fcbecbb1-scaled.png)

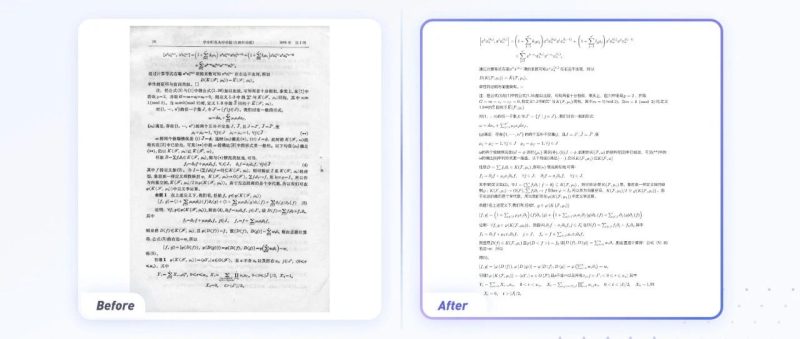

几何表征:推理的三阶段演化

探针实验进一步揭示了 Transformer 内部如何实现这一推理过程。作者将其描述为一个三阶段的几何演化机制。

1. 假设框架构建 (Layer 0)

推理始于坐标系的建立。第 0 层的 Key 向量形成了一个 近似正交的基底 (Orthogonal Basis),将所有可能的假设映射到独立的几何子空间中。

![图片[48]-优化即几何,几何即推理:用数学终结Transformer的黑盒时代-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260102194459292-1767354299-851739c3cafcfc612033b58354a6e65a.png)

2. 渐进式假设消除 (Middle Layers)

随着层数加深,Attention 的路由 (Routing) 功能逐渐显现。Query 和 Key 的对齐程度呈现显著的锐化 (Sharpening) 趋势。

这一过程在数学上等价于贝叶斯更新中似然函数的乘法操作,逐层抑制与当前证据不符的假设。

![图片[68]-优化即几何,几何即推理:用数学终结Transformer的黑盒时代-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260102194500612-1767354300-22b1aca48fe83d0d0b0418e94417f457.png)

3. 熵有序流形 (Late Layers)

当路由结构稳定后,Value 向量 () 在表示空间中并未坍缩为离散点,而是展开成一条光滑的一维流形 (1D Manifold)。

该流形的参数化坐标精确对应于后验熵 (Posterior Entropy)。

![图片[69]-优化即几何,几何即推理:用数学终结Transformer的黑盒时代-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260102194501889-1767354301-e4d29a6280fc4a63ece6358f194f02e1.png)

![图片[75]-优化即几何,几何即推理:用数学终结Transformer的黑盒时代-AI Express News](https://www.aiexpress.news/wp-content/uploads/2025/12/20251215190821782-1765796901-6e53d0e2487a08c269915621d3add898-scaled.png)

动力学溯源:梯度下降的诱导机制

为何标准的梯度下降能够自发产生上述几何结构?

Paper II 通过全套一阶梯度动力学推导,发现交叉熵损失诱导了一套精妙的正反馈机制。

![图片[89]-优化即几何,几何即推理:用数学终结Transformer的黑盒时代-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260102194501474-1767354301-12c5f3603196858f80820be6e7651b2b.png)

论文标题:

Gradient Dynamics of Attention: How Cross-Entropy Sculpts Bayesian Manifolds

论文链接:

https://arxiv.org/abs/2512.22473

1. 优势路由法则 (E-step)

Attention Score () 的梯度遵循以下公式:

![图片[116]-优化即几何,几何即推理:用数学终结Transformer的黑盒时代-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260102194501317-1767354301-daed458ce1ddb8bb2bbc413d65feaf0b.png)

其中 。定义 Advantage 。

物理含义:这里 代表误差梯度方向。当 与误差方向相反(即 越负,有助于减少 Loss)时,Advantage 为正。

结论:梯度下降会增加那些能有效减少 Loss 的位置的注意力权重。

2. 责任加权更新法则 (M-step)

Value () 的更新遵循以下公式:

![图片[117]-优化即几何,几何即推理:用数学终结Transformer的黑盒时代-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260102194501339-1767354301-8d27c82c072621fef90884f30cb55e6f.png)

物理含义:Value 向量会被拉向所有关注它的 Query 的上游误差信号 () 的加权平均方向,逐步演化为该簇 Query 的“原型” (Prototype)。

![图片[118]-优化即几何,几何即推理:用数学终结Transformer的黑盒时代-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260102194502843-1767354302-7657cbd76ea51c72ad4a72c0b33c799e.png)

Value 向误差信号 移动,优化 Context ,进而增加兼容性 (使其更负),形成路由与内容的协同演化闭环。

这一动力学过程在结构上等价于隐式的 EM 算法 (Expectation-Maximization)。Attention 权重充当 E 步的“软责任”,而 Value 向量充当 M 步的“原型”。

这也解释了框架-精度解离 (Frame-Precision Dissociation) 现象。Attention 结构通常在训练早期快速稳定,而 Value 内容则在剩余训练中持续在流形上精修。

![图片[119]-优化即几何,几何即推理:用数学终结Transformer的黑盒时代-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260102194503437-1767354303-e661c7915bef4898ce47fb6144b4ffe4-scaled.png)

现实映射:从叠加态到思维链

虽然上述结论基于受控环境,但作者在博客 [3] 中指出,在 Pythia, Llama, Mistral 等生产级模型中,同样观察到了类似的几何特征。

关键在于叠加态 (Superposition):在混合任务中,流形结构往往被高维噪声掩盖;但通过领域限制 (Domain Restriction)(如仅关注数学任务),高维表征会坍缩为清晰的熵有序流形 。

![图片[133]-优化即几何,几何即推理:用数学终结Transformer的黑盒时代-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260102194503543-1767354303-ba099f047430e53607af8af3f63a9ba4.png)

这一发现为 Chain-of-Thought (CoT) 提供了清晰的几何解释。

对于复杂推理任务,Transformer 面临层数耗尽 (Run out of layers) 的风险,无法在有限的计算步数内完成所有必要的假设消除。

CoT 本质上起到了几何延展器 (Geometric Extender) 的作用。

通过生成中间推理步骤,模型实际上获得了更多的计算轮次,使其能够沿着高置信度的“熵有序流形”进行一系列短距离、稳健的状态转移,从而避免了在低置信度区域进行长距离跳跃所引发的幻觉。

这项研究提供了一个统一的视角来理解 Transformer 的智能本质。优化产生几何,几何产生推理 (Optimization gives rise to geometry. Geometry gives rise to inference.) 。

参数矩阵并非随机的统计近似,而是梯度流在交叉熵势能面上“雕刻”出的贝叶斯推理机。

Attention 机制从几何动力学的角度来看,正是这一推理过程的物理载体。

参考文献

更多阅读

![图片[137]-优化即几何,几何即推理:用数学终结Transformer的黑盒时代-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260102194506547-1767354306-eb65fd34228b55e1de39f436fe51754b.png)

![图片[138]-优化即几何,几何即推理:用数学终结Transformer的黑盒时代-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260102194507424-1767354307-e377e46a4140520e1d742dabfec14579.png)

![图片[139]-优化即几何,几何即推理:用数学终结Transformer的黑盒时代-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260102194507945-1767354307-4bc008af52d46cc3066514224547c839.png)

![图片[140]-优化即几何,几何即推理:用数学终结Transformer的黑盒时代-AI Express News](https://www.aiexpress.news/wp-content/uploads/2025/12/20251219232226601-1766157746-60dbf30d73ded5ade8ec5f4ba1d9d873.gif)

#投 稿 通 道#

让你的文字被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

📝 稿件基本要求:

• 文章确系个人原创作品,未曾在公开渠道发表,如为其他平台已发表或待发表的文章,请明确标注

• 稿件建议以 markdown 格式撰写,文中配图以附件形式发送,要求图片清晰,无版权问题

• PaperWeekly 尊重原作者署名权,并将为每篇被采纳的原创首发稿件,提供业内具有竞争力稿酬,具体依据文章阅读量和文章质量阶梯制结算

📬 投稿通道:

• 投稿邮箱:hr@paperweekly.site

• 来稿请备注即时联系方式(微信),以便我们在稿件选用的第一时间联系作者

• 您也可以直接添加小编微信(pwbot02)快速投稿,备注:姓名-投稿

![图片[154]-优化即几何,几何即推理:用数学终结Transformer的黑盒时代-AI Express News](https://www.aiexpress.news/wp-content/uploads/2025/12/20251219232226784-1766157746-5cbb2d512b2d7f9dc4e61829e1d83577.png)

△长按添加PaperWeekly小编

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧

![图片[181]-优化即几何,几何即推理:用数学终结Transformer的黑盒时代-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260102194507517-1767354307-ce5f781a0e98c6458175ba94804c197c.jpeg)

<原文链接:https://mp.weixin.qq.com/s/uTEx3FrJjBNrBwvOunTBiQ

暂无评论内容