![图片[1]-拒绝蜡像感!美团开源LongCat-Video-Avatar:5分钟超长续航,虚拟人终于会呼吸了-AI Express News](https://www.aiexpress.news/wp-content/uploads/2025/12/20251208235640308-1765209400-bd9bc6838679ed2ca2d7558267214b8d.gif)

捅破 5 分钟长续航天花板,SOTA 级权重直接全开源。

2025 年,视频生成赛道已经进入了卷细节、卷长时序的深水区。

当行业已经能够产出几秒钟极具视觉冲击力的镜头时,实际落地中却总会撞上几堵隐形的墙:长视频生成中不可避免的身份漂移(Identity Drift)、声音消失后的蜡像化冻结,以及反复 VAE 编解码导致的画质退化。

继今年 8 月吸引全球开发者关注的 InfiniteTalk 之后,美团龙猫(LongCat)团队最近又有了一些新动作。

这次,他们基于自研的 13.6B 参数原生视频生成基座 LongCat-Video,正式发布并开源了专门针对数字人优化的 LongCat-Video-Avatar。

这不仅是一个能原生支持音文生视频(AT2V)、音图文生视频(ATI2V)以及视频续写等多种生成模式的统一架构,更重要的是,它在虚拟人的动作拟真度和超长视频稳定性上实现了明显的突破。

![图片[2]-拒绝蜡像感!美团开源LongCat-Video-Avatar:5分钟超长续航,虚拟人终于会呼吸了-AI Express News](https://www.aiexpress.news/wp-content/uploads/2025/12/20251216182813636-1765880893-64eee74568d1b0ec06754200fb3eab1a-scaled.png)

虚拟人终于有了松弛感

为了看清它到底强在哪,我们拆解了官方展示的几个场景。最直观的感受是,现在的虚拟人真的很难再用“假”来形容了。

先看这段美妆博主的日常护肤评测,LongCat 表现得非常老道。

从大笑转到悲伤的情绪转折处理得很细腻,镜头离得这么近,肌肉牵动和眼角纹理都很清楚。最关键的是长相特征稳得不行,大开大合的表情之下一点没走样。

能入戏只是基础,几分钟长跑不穿帮才是真硬核。

我们试着快进到这段 5 分钟长视频的最后,画面质感和肤色依然很稳。没出现那种越往后越崩、甚至像素雪崩的情况,这稳定性在目前开源圈确实罕见。

不过,数字人最难的其实不是独角戏,而是两个角色同台时的那种化学反应。

录音棚里的这场对白戏,不仅是口型卡得准,眼神交流和动作回馈的同步感也很有真人的互动氛围,完全没有各演各的割裂感。

如果把这种互动节奏放到播客访谈里,就更实用了。

这种长时段的访谈最看重连贯性,哪怕是低头想个词,角色的神态也没断过。这种表现力拿去剪播客或者做网课基本能直接用,确实有老戏骨的潜质。

![图片[17]-拒绝蜡像感!美团开源LongCat-Video-Avatar:5分钟超长续航,虚拟人终于会呼吸了-AI Express News](https://www.aiexpress.news/wp-content/uploads/2025/12/20251216182816328-1765880896-04606631342c154e01b1096c4f4bc4f5-scaled.png)

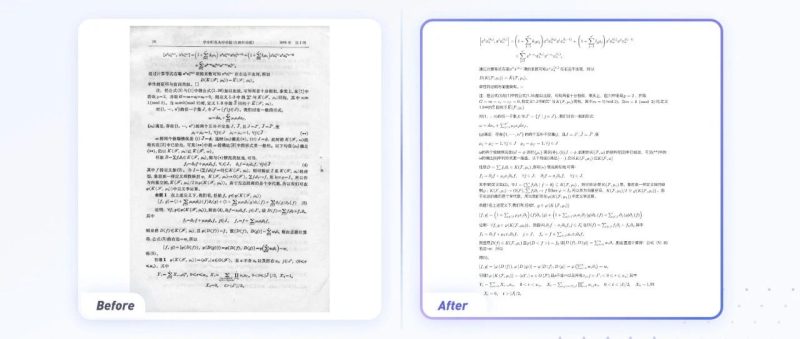

性能评测:稳站 SOTA 第一梯队

视觉表现够出彩,底层的硬核指标也同样撑得起这个 SOTA 段位。

在与目前主流视频模型的横向对比中,LongCat-Video-Avatar 在多个核心维度都拿出了顶尖的竞争力。

全身生成的极致画质:在衡量保真度的核心指标 FID 上,模型在自研的 EMTD 全身视频数据集上跑出了 65.05 的成绩。

![图片[32]-拒绝蜡像感!美团开源LongCat-Video-Avatar:5分钟超长续航,虚拟人终于会呼吸了-AI Express News](https://www.aiexpress.news/wp-content/uploads/2025/12/20251219232055567-1766157655-8bcc6e28712b4173580e0fc1dd37b92f.png)

对比来看,包括 Hallo3、InfiniteTalk 在内的几种主流模型,在这个指标上基本都在 110 甚至更高的区间徘徊。这种断层式的领先,意味着它的全身动态已经非常接近真实拍摄的质感。

唇形精度超越行业标杆:在衡量口型准度的 Sync-C 指标上,它在多个考场均取得 SOTA 成绩,在 EvalTalker 评测中甚至超越了 HeyGen、Kling Avatar 2.0 等一众顶级闭源商业模型。

![图片[33]-拒绝蜡像感!美团开源LongCat-Video-Avatar:5分钟超长续航,虚拟人终于会呼吸了-AI Express News](https://www.aiexpress.news/wp-content/uploads/2025/12/20251219232056143-1766157656-da2f97191307e9f98fd165cb0fd0e030.png)

此外,官方还组织了 492 名参与者进行了大规模盲测。数据证明,模型在静音段表现、长视频稳定性和动作多样性三个维度均获得了显著的正向反馈。

![图片[34]-拒绝蜡像感!美团开源LongCat-Video-Avatar:5分钟超长续航,虚拟人终于会呼吸了-AI Express News](https://www.aiexpress.news/wp-content/uploads/2025/12/20251219232056351-1766157656-e7da22da32c8fee3b8c190e8ee92a399.png)

![图片[35]-拒绝蜡像感!美团开源LongCat-Video-Avatar:5分钟超长续航,虚拟人终于会呼吸了-AI Express News](https://www.aiexpress.news/wp-content/uploads/2025/12/20251216182818831-1765880898-cd984cb2fb1b75cbc94aa1ddca5beed9-scaled.png)

技术架构解析:虚拟人如何找回生命力?

美团龙猫团队在技术报告里分享了三项核心改进,从底层架构层面彻底重塑了虚拟人的生成逻辑。

1. 解耦无条件引导

传统训练常使用全零音频向量代表静音,这会导致模型产生条件泄露(Condition Leakage)。它分不清你是想表达“静音”,还是“没有任何条件约束”。

龙猫团队引入了 DUG 策略(Disentangled Unconditional Guidance),训练时直接输入真实的静音音频编码。这种做法让模型在推理阶段对无音频输入具有极强的鲁棒性,让虚拟人在没台词时依然能自然呼吸、眨眼。

![图片[50]-拒绝蜡像感!美团开源LongCat-Video-Avatar:5分钟超长续航,虚拟人终于会呼吸了-AI Express News](https://www.aiexpress.news/wp-content/uploads/2025/12/20251219232057316-1766157657-ffbd69ef6573b18de6e536f04f07838d.png)

龙猫团队在研发中对参考帧的位置做了详尽实验。他们发现,将参考帧放在开头或结尾(Prefix/Suffix),引导强度会不足导致细节丢失;而放中间(Middle)虽然保住了细节,却会引发死板的复制-粘贴效应。

最终的最优解是:放中间 + RSA 机制(Reference Skip Attention)。RSA 在注意力权重上做了硬掩码(Hard-mask)处理,模型只去采样参考图里的痣、皮肤纹理等核心 ID 特征,而屏蔽姿态、动作的直接干预。

![图片[51]-拒绝蜡像感!美团开源LongCat-Video-Avatar:5分钟超长续航,虚拟人终于会呼吸了-AI Express News](https://www.aiexpress.news/wp-content/uploads/2025/12/20251219232057113-1766157657-eb86237348f33853ca36e96383dc75b9.png)

3. 跨片段隐空间拼接

龙猫团队提出的 CLS 策略(Cross-Chunk Latent Stitching),允许模型直接在隐空间(Latent Space)内拼接重叠片段。这种做法彻底消除了冗余 VAE 循环带来的累积偏差,是 5 分钟视频稳如泰山的幕后功臣。

![图片[52]-拒绝蜡像感!美团开源LongCat-Video-Avatar:5分钟超长续航,虚拟人终于会呼吸了-AI Express News](https://www.aiexpress.news/wp-content/uploads/2025/12/20251219232058448-1766157658-92e55fb77859ed53512b422d10be2d02.png)

在工程实现上,团队采用了 16 FPS 和 25 FPS 的混合训练策略,并专门针对 16 FPS 模式等比缩小了音频特征提取窗口,从算法层面解决了对位难题。

此外,针对多人对话场景,模型通过自注意力图计算参考帧与视频帧的相似度,在隐空间内精准划分画面区域,再配合 L-ROPE 贴签,彻底解决了互动中的音画错位。

![图片[53]-拒绝蜡像感!美团开源LongCat-Video-Avatar:5分钟超长续航,虚拟人终于会呼吸了-AI Express News](https://www.aiexpress.news/wp-content/uploads/2025/12/20251219232058107-1766157658-fa562dfada6ee0ded1400050c2e36816.png)

结语

现在的视频生成领域,闭源 API 固然强大,但往往是不可见的黑盒。

美团龙猫团队这次把底层架构、SOTA 级别的权重,甚至是多人绑定的 L-ROPE 机制全部开源,无疑是给国内数字人研究社区提供了一个极高起点的进化基座。

LongCat-Video-Avatar 不仅给开发者们提供了一个稳、准、活的生产力工具 ,更重要的是,它通过对底层逻辑的微调,让虚拟人开始拥有了真人的那种灵动感。

项目入口👇

GitHub:

https://github.com/meituan-longcat/LongCat-Video

Hugging Face:

https://huggingface.co/meituan-longcat/LongCat-Video-Avatar -

Project Page:

https://meigen-ai.github.io/LongCat-Video-Avatar/

<原文链接:https://mp.weixin.qq.com/s/zJcP7gjYT_NVEyxqaAz62Q

暂无评论内容