![图片[1]-RK-∞降维打击Mamba?线性注意力真的有“免费午餐”!-AI Express News](https://www.aiexpress.news/wp-content/uploads/2025/12/20251208235640308-1765209400-bd9bc6838679ed2ca2d7558267214b8d.gif)

这顿“免费午餐”,或许正是通向长文本高保真建模的下一块基石。

在大模型迈向超长上下文的当下,混合注意力(Hybrid Attention)已成为 MiniMax、Qwen、Kimi 及 NVIDIA 等厂商竞相采用的技术底座。其核心逻辑通常是利用 Softmax 注意力捕捉近距离依赖,配合线性注意力或状态空间模型(SSMs)处理远距离背景。

然而,作为一种长期被视为“次优近似”的组件,线性注意力在超长序列下始终难以摆脱数值漂移和记忆退化的问题。

南洋理工大学与复旦大学的一项最新工作,把矛头直接指向了这一问题最容易被忽略的根源:问题不在模型结构,而在数值方法。

研究者提出了 EFLA(Error-Free Linear Attention),指出我们过去一直用一阶欧拉法去离散一个本应精确求解的连续动力学系统,才是导致不稳定和性能退化的根源。

更关键的是,这项工作证明,在保持线性时间复杂度不变的前提下,通过引入无限阶 Runge–Kutta 级别的解析解,可以彻底消除离散化误差。

这意味着线性注意力第一次不再以“近似”为代价:在不增加任何参数的情况下,实现了稳定性与性能的同步提升,并在多个基准上超越了 DeltaNet 等主流方案。

![图片[2]-RK-∞降维打击Mamba?线性注意力真的有“免费午餐”!-AI Express News](https://www.aiexpress.news/wp-content/uploads/2025/12/20251218233313457-1766071993-2bf7735ab0e88020550a4cacac53c755.png)

论文标题:

Error-Free Linear Attention is a Free Lunch: Exact Solution from Continuous-Time Dynamics

论文链接:

https://arxiv.org/abs/2512.12602

代码链接:

https://github.com/declare-lab/EFLA

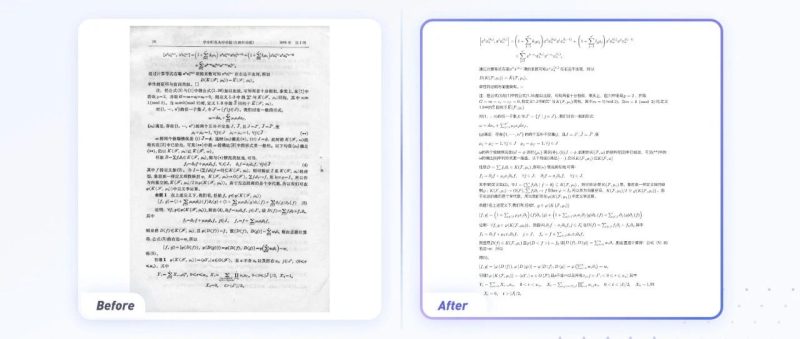

![图片[3]-RK-∞降维打击Mamba?线性注意力真的有“免费午餐”!-AI Express News](https://www.aiexpress.news/wp-content/uploads/2025/12/20251216182813636-1765880893-64eee74568d1b0ec06754200fb3eab1a-scaled.png)

研究背景

当大语言模型进化为需要处理超长推理轨迹的 Agent 时,标准注意力的二次方复杂度成了不可逾越的鸿沟。

线性注意力试图通过维护一个矩阵状态 来存储键值对关联,从而实现线性推理:

![图片[15]-RK-∞降维打击Mamba?线性注意力真的有“免费午餐”!-AI Express News](https://www.aiexpress.news/wp-content/uploads/2025/12/20251218233313754-1766071993-e9e38e3114aed336b5c19909aedc395d.png)

但这种无限制的累加会导致记忆干扰和状态爆炸。为了解决这一问题,DeltaNet 将状态更新建模为对重构损失的在线梯度下降:

![图片[16]-RK-∞降维打击Mamba?线性注意力真的有“免费午餐”!-AI Express News](https://www.aiexpress.news/wp-content/uploads/2025/12/20251218233314557-1766071994-7e17066785472efed0a219cf94742058.png)

由此推导出的 Delta Rule 更新公式如下:

![图片[17]-RK-∞降维打击Mamba?线性注意力真的有“免费午餐”!-AI Express News](https://www.aiexpress.news/wp-content/uploads/2025/12/20251218233314198-1766071994-1157cc4151f1b774b6bbbec572c9bbfa.png)

这正是问题的根源所在。论文指出,这一更新步骤在数学本质上等效于对一个一阶线性常微分方程(ODE)进行一阶显式欧拉离散化。

该底层的连续时间 ODE 为:

![图片[18]-RK-∞降维打击Mamba?线性注意力真的有“免费午餐”!-AI Express News](https://www.aiexpress.news/wp-content/uploads/2025/12/20251218233315792-1766071995-5ece029c6c9c23b35314479e6252789b.png)

其中 为动力学矩阵, 为输入强制项。

数值分析表明,欧拉法的局部截断误差高达 。在处理长上下文或刚性(Stiff)动力学系统时,这种低阶近似会导致误差迅速累积,表现为记忆的过早遗忘或数值漂移。

此前诸如门控(Gating)或自适应遗忘系数等尝试,本质上只是对低阶误差的启发式修正。

![图片[19]-RK-∞降维打击Mamba?线性注意力真的有“免费午餐”!-AI Express News](https://www.aiexpress.news/wp-content/uploads/2025/12/20251216182816328-1765880896-04606631342c154e01b1096c4f4bc4f5-scaled.png)

核心方法

作者提出,消除误差的终极方案不是去优化离散化步长,而是直接寻找底层 ODE 的解析解。

2.1 解析解的导出

基于数字系统中常用的零阶保持(ZOH)假设,状态在每个时间步内的演化可以看作是在 piecewise constant 的 和 下进行的。

该 ODE 在步长 内的通用解析解为:

![图片[31]-RK-∞降维打击Mamba?线性注意力真的有“免费午餐”!-AI Express News](https://www.aiexpress.news/wp-content/uploads/2025/12/20251218233316666-1766071996-cab89a53c0a5aff4256121283ea5c374.png)

这个解析解代表了数值积分中 Runge-Kutta 家族的无限阶极限(RK-)。

2.2 利用 Rank-1 结构突破计算瓶颈

通常计算矩阵指数 需要 的复杂度。但 EFLA 的设计者捕捉到了一个极其关键的数学特性:动力学矩阵 是一个秩-1(Rank-1)矩阵。

秩-1 矩阵具有幂等相关的特殊属性:,其中 。利用这一性质,矩阵指数的泰勒展开可以直接塌缩为一个简洁的闭式解:

![图片[32]-RK-∞降维打击Mamba?线性注意力真的有“免费午餐”!-AI Express News](https://www.aiexpress.news/wp-content/uploads/2025/12/20251218233316758-1766071996-988ce2756f10dc9ee6f1906920caa39e.png)

将此项代入积分项并经过严谨的代数简化,最终得到了 EFLA 的精确更新规则:

![图片[33]-RK-∞降维打击Mamba?线性注意力真的有“免费午餐”!-AI Express News](https://www.aiexpress.news/wp-content/uploads/2025/12/20251218233317986-1766071997-29247a3d58be30b2ecdabfb240557cc7.png)

这一公式在消除离散化误差的同时,计算复杂度仍维持在 。这证明了在 Rank-1 约束下,解析解是“免费”获得的。

3.3 光谱门控(Spectral Gate)与遗忘机制

不同于 DeltaNet 强制要求对 Key 进行 归一化,EFLA 使用非归一化 Key。在此框架下, 充当了光谱门控(Spectral Gate)的角色:

强输入信号(大 Key 范数):会导致状态沿着 方向发生快速的指数级衰减,迅速清理旧槽位以为新信息腾空间。

弱输入信号(小 Key 范数):则表现为缓慢的衰减,最大程度保留历史背景。这种方向性衰减机制使得 EFLA 具备了比传统线性注意力更强的记忆动态管理能力。

3.4 对标 Mamba:阶数的代际压制

这是一个非常有趣的对比点。现代 SSM 模型如 Mamba 通常采用双线性变换进行离散化,这在数学上等价于隐式二阶 Runge-Kutta 方法。而 EFLA 通过剥离 Rank-1 矩阵指数,直接跨越到了 RK-∞ 级别。

这意味着在理论数值精度上,EFLA 对现有的有限阶 SSM 构成了一次降维打击。

![图片[34]-RK-∞降维打击Mamba?线性注意力真的有“免费午餐”!-AI Express News](https://www.aiexpress.news/wp-content/uploads/2025/12/20251216182818831-1765880898-cd984cb2fb1b75cbc94aa1ddca5beed9-scaled.png)

实验结果

作者通过 sMNIST 和大规模语言建模实验验证了 EFLA 的优越性。

3.1 鲁棒性压力测试

在 Sequential MNIST (sMNIST) 任务中,作者通过人为引入像素丢失、信号缩放和高斯噪声来模拟极端不稳定的输入环境。

![图片[46]-RK-∞降维打击Mamba?线性注意力真的有“免费午餐”!-AI Express News](https://www.aiexpress.news/wp-content/uploads/2025/12/20251218233317666-1766071997-8e691bdf1251e3854aae82f3fe816cda.png)

实验揭示了两个关键现象:

对抗信号爆炸:当输入被放大(Scale 增加)时,基于一阶近似的 DeltaNet 性能迅速崩溃,确认了低阶近似在处理高能信号时的脆弱性。而 EFLA 依靠精确的指数饱和机制有效防止了状态爆炸。

高保真记忆:在噪声干扰下,EFLA 的性能退化速度远慢于基线,证明其构建了更高保真的记忆表示。

3.2 语言建模能力评估

在大规模实验中,EFLA 全面超越了 DeltaNet 基准。

![图片[47]-RK-∞降维打击Mamba?线性注意力真的有“免费午餐”!-AI Express News](https://www.aiexpress.news/wp-content/uploads/2025/12/20251218233318560-1766071998-d9be4ca45c7eaa26111697676282d29d.png)

从表 1 数据可以清晰看到:

在 LAMBADA 任务上,EFLA 将 Perplexity 从 96.26 压低至 81.28(340M 规模)。在 BoolQ 准确率上,EFLA 实现了 +7.4% 的巨大飞跃。

这些结果有力地证明了,通过消除数值离散化误差,模型能够显著提升对长序列历史信息的保留精度。

3.3 反直觉的优化策略:更大的学习率

实验发现,EFLA 由于存在指数级的饱和效应(Saturation effect),可能导致梯度信号在收敛阶段受阻。

![图片[48]-RK-∞降维打击Mamba?线性注意力真的有“免费午餐”!-AI Express News](https://www.aiexpress.news/wp-content/uploads/2025/12/20251218233319578-1766071999-457d3a0f61cc29d5997c08afaf44b84c.png)

如图 2 所示,相比传统的保守策略,EFLA 在更大的学习率下展现出更强的鲁棒性。这种反直觉的超参数设置是释放其理论潜力的关键要素。

![图片[49]-RK-∞降维打击Mamba?线性注意力真的有“免费午餐”!-AI Express News](https://www.aiexpress.news/wp-content/uploads/2025/12/20251216182822780-1765880902-ca7934f880ff96ea9c8c3087479f6af4-scaled.png)

结语

EFLA 是一项具有高度理论美感的成果。它向我们证明了,线性注意力长期以来的性能瓶颈并非由于架构本身的基因缺陷,而是源于我们在数值实现上的粗糙妥协。

通过利用 Rank-1 特性绕过复杂的数值积分,EFLA 在不增加计算成本的前提下,实现了从一阶欧拉近似到无限阶解析解的跨越。

对于目前正处于混合注意力深水区的工业界而言,EFLA 提供了一套直接且高效的升级路径。它告诉我们,最优雅、最强力的解决方案往往就藏在最底层的连续时间方程之中。

暂无评论内容