![图片[1]-0.6B参数逆袭7B基线?OpenTrackVLA重磅开源:重写具身智能的算力法则-AI Express News](https://www.aiexpress.news/wp-content/uploads/2025/12/20251208235640308-1765209400-bd9bc6838679ed2ca2d7558267214b8d.gif)

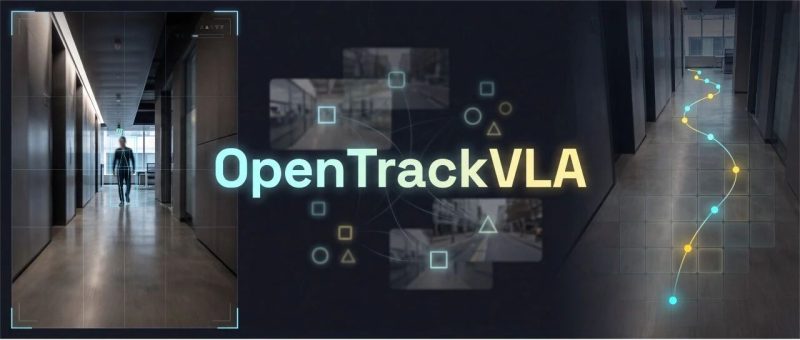

当大模型还在卷参数量时,具身智能的角斗场已经转移到了端侧落地的实战。0.6B 参数能否承载复杂的视觉-语言-动作联合推理?OpenTrackVLA 给出了一个意想不到的解法。

12 月 12 日,GDPS 2025(全球开发者先锋大会)在上海开幕。

作为具身智能领域的年度风向标,本次大会最让技术圈兴奋的,莫过于联汇科技一口气开源了两大核心成果:VLM-FO1 与 OpenTrackVLA。

![图片[2]-0.6B参数逆袭7B基线?OpenTrackVLA重磅开源:重写具身智能的算力法则-AI Express News](https://www.aiexpress.news/wp-content/uploads/2025/12/20251216182812684-1765880892-18bf413e9bfeef46001bd7ab66e9c1be.png)

这两项成果恰好击中了具身智能落地的两极:

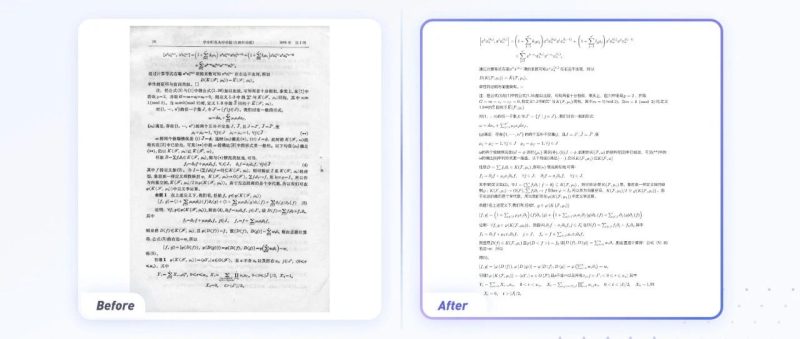

VLM-FO1 专注于解决大模型“看得懂但指不准”的精细化感知痛点,通过即插即用的增强框架实现了像素级的空间定位能力。

它有效弥合了高层语义推理与底层细粒度感知之间的鸿沟,且完全不损耗原模型的通用能力。

关于 VLM-FO1 的技术细节,我们在之前的文章中已经做过深度拆解,感兴趣的读者可以点击回顾。

OpenTrackVLA 则是今天我们要硬核拆解的主角——另一款小而美的端侧杀手锏。

这是一个完全开源的视觉-语言-动作(VLA)系统,其核心亮点在于以 0.6B(6亿)的极致轻量化参数,在保证核心跟踪性能的前提下,彻底打通了从数据处理到模型训练的全栈开源路径。

小参数如何撬动高性能?OpenTrackVLA 并没有选择堆砌算力,而是走了一条架构换效率与工程化破局的极客路线。

![图片[3]-0.6B参数逆袭7B基线?OpenTrackVLA重磅开源:重写具身智能的算力法则-AI Express News](https://www.aiexpress.news/wp-content/uploads/2025/12/20251216182813636-1765880893-64eee74568d1b0ec06754200fb3eab1a-scaled.png)

告别黑盒式开源

在 OpenTrackVLA 出现之前,具身视觉跟踪(Embodied Visual Tracking)领域其实并不缺 SOTA 模型。

比如奠基之作 TrackVLA (arXiv:2505.23189),虽然证明了 VLA 模型在野外环境下的强大潜力,但它却给开发者留下了一个巨大的遗憾——未开源训练技术栈(Training Stack)。

这就好比给了你一辆跑车,却锁死了引擎盖。如果你想复现论文效果,或者想用自己的数据微调模型来适应特定场景(比如仓库、医院),你会发现面前竖着一堵隐形的墙。

![图片[6]-0.6B参数逆袭7B基线?OpenTrackVLA重磅开源:重写具身智能的算力法则-AI Express News](https://www.aiexpress.news/wp-content/uploads/2025/12/20251216182815981-1765880895-0722181c0e1aeab3b38b724c2d28031a.png)

OpenTrackVLA 的设计初衷,正是为了推倒这堵墙。

它的核心使命是 Democratizing Embodied AI(具身智能民主化):提供一套从数据预处理、特征缓存到模型训练的全栈开源工具链,让无论手握 H100 的实验室大牛,还是只有消费级显卡的学生,都能参与到具身智能的创新中来。

![图片[9]-0.6B参数逆袭7B基线?OpenTrackVLA重磅开源:重写具身智能的算力法则-AI Express News](https://www.aiexpress.news/wp-content/uploads/2025/12/20251216182816328-1765880896-04606631342c154e01b1096c4f4bc4f5-scaled.png)

极致轻量的双眼架构

OpenTrackVLA 之所以能在 0.6B 参数下实现高效推理,核心在于其精炼的模型架构设计。它抛弃了臃肿的通用大模型,转而采用了一个基于 Qwen-0.6B 微调的专用规划器(Planner)。

![图片[12]-0.6B参数逆袭7B基线?OpenTrackVLA重磅开源:重写具身智能的算力法则-AI Express News](https://www.aiexpress.news/wp-content/uploads/2025/12/20251216182817952-1765880897-194f080068b8750a3fa432c9a020e240.png)

从架构图中,我们可以看到支撑其高性能的三个关键支柱。

1. “双眼”看世界(混合视觉编码)

模型并没有只用一种视觉特征,而是采用了双流策略,兼顾宏观与微观:

一只眼看结构(DINOv3):利用 DINOv3 (ViT-S/16) 捕捉目标性(Objectness)。它对边界、形状等结构线索极其敏感,负责在复杂的背景中把物体一个个“抠”出来;

一只眼懂语义(SigLIP):利用 SigLIP (SO400M) 强化语言理解。它擅长处理颜色、类别等属性信息,负责将视觉信号与指令对齐,搞清楚“哪个才是你要找的红衣人”。

这两路特征拼接后,模型既有对物理边界的敏锐感知,又能精准响应复杂的语言指令。

2. TVI 上下文嵌入

小模型最怕在长序列视频中晕头转向。OpenTrackVLA 引入了 TVI (Temporal-View-Instruction) Embedding。

这相当于给进入模型的每个数据打上了时间戳、视角和指令类型的标签,告诉 Qwen-0.6B:“这是第 5 秒的画面,请注意”。

这种显式的上下文提示,极大降低了小模型的推理难度。

3. 直出路点(Planner Head)

不同于让大模型生成“向左转”这种模糊的文本,OpenTrackVLA 在输出层接了一个简单的 3 层 MLP 网络。它直接回归生成未来的短时路点序列 (x, y, yaw)。

这一串精确的坐标数值,机器人拿到就能直接执行,实现了从感知到决策的端到端闭环。

![图片[13]-0.6B参数逆袭7B基线?OpenTrackVLA重磅开源:重写具身智能的算力法则-AI Express News](https://www.aiexpress.news/wp-content/uploads/2025/12/20251216182818831-1765880898-cd984cb2fb1b75cbc94aa1ddca5beed9-scaled.png)

工程创新:原生支持分布式

除了模型架构,OpenTrackVLA 对开发者的最大诚意在于其工程级的优化。

传统的 VLA 训练通常是显卡杀手,因为需要在训练过程中实时处理海量视频帧,显存分分钟爆满。而 OpenTrackVLA 引入了一套特征预缓存(Vision Token Precaching)的巧妙工程化设计:

![图片[16]-0.6B参数逆袭7B基线?OpenTrackVLA重磅开源:重写具身智能的算力法则-AI Express News](https://www.aiexpress.news/wp-content/uploads/2025/12/20251216182820940-1765880900-da1d2c4ddc55145c74e297feb43fdc29.png)

它提供了一个 precache_frames.py 脚本,允许开发者在离线状态下,先把所有视频帧的 DINOv3 和 SigLIP 特征提取出来存入硬盘。等到真正训练时,模型直接读取硬盘里的特征(Vision Tokens)。

这一招把训练过程从 GPU 密集型变成了 I/O 密集型,大幅降低了硬件门槛,让普通 GPU 也能跑得动 VLA 训练。

此外,OpenTrackVLA 的工程成熟度极高:

开箱即用:官方在 HuggingFace 提供了预训练权重(omlab/opentrackvla-qwen06b),配合简单的

eval.sh脚本,开发者可以一键复现评估结果,无需从零开始训练。企业级支持:原生支持 PyTorch DDP 分布式训练,无论是单卡微调还是多卡并行加速,都能通过标准化的参数配置轻松搞定。

![图片[17]-0.6B参数逆袭7B基线?OpenTrackVLA重磅开源:重写具身智能的算力法则-AI Express News](https://www.aiexpress.news/wp-content/uploads/2025/12/20251216182822780-1765880902-ca7934f880ff96ea9c8c3087479f6af4-scaled.png)

结语

在 EVT-Bench 的实测中,OpenTrackVLA 以 0.6B 的参数量在静态目标跟踪任务中实现了 84.4% 的跟踪率(TR),充分验证了这套轻量级架构在“跟得紧”这一核心能力上的可行性。

下图展示了 OpenTrackVLA 在复杂室内环境下的实时跟踪效果:

![图片[20]-0.6B参数逆袭7B基线?OpenTrackVLA重磅开源:重写具身智能的算力法则-AI Express News](https://www.aiexpress.news/wp-content/uploads/2025/12/20251216182825145-1765880905-c7bbea87ac03ad01ab25182bb8a06bd7.gif)

![图片[21]-0.6B参数逆袭7B基线?OpenTrackVLA重磅开源:重写具身智能的算力法则-AI Express News](https://www.aiexpress.news/wp-content/uploads/2025/12/20251216182827625-1765880907-5c72c90ac52618db2e01b3e1887c4959.gif)

虽然在绝对成功率上相比大模型仍有优化空间,但这正是 OpenTrackVLA 选择将全栈工具链彻底开源的原因。

它不再是一个封闭的黑盒产品,而是一块已经打好地基的开源试验田。

对于开发者而言,你现在拥有了一个目前最完整的开源 VLA 工具箱:

完全开源:代码、数据、工具链,毫无保留;

极低门槛:基于 Qwen-0.6B,消费级硬件友好;

持续演进:官方已透露未来将探索 8B/30B 版本,并期待你的 Pull Request。

如果你想亲手训练一个能听懂人话的机器人,却又苦于没有算力,OpenTrackVLA 或许是你目前最好的选择。

项目传送门👇

GitHub 地址:

https://github.com/om-ai-lab/OpenTrackVLA

HuggingFace 地址:

https://huggingface.co/omlab/opentrackvla-qwen06b

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧

![图片[24]-0.6B参数逆袭7B基线?OpenTrackVLA重磅开源:重写具身智能的算力法则-AI Express News](https://www.aiexpress.news/wp-content/uploads/2025/12/20251208235652493-1765209412-f3d8c69b26570e8d27cd9240587c73a8.jpeg)

<原文链接:https://mp.weixin.qq.com/s/Bf_xEZlpEGDteXXHdfm5Qg

暂无评论内容