Black Forest Labs开源了FLUX.2 [klein]模型家族,这是目前最快的图像生成模型系列。该系列在单一紧凑架构中统一了生成和编辑能力,在现代硬件上实现端到端推理低至0.5秒以内,同时在消费级GPU上仅需13GB显存即可运行。

![图片[1]-FLUX.2-Klein 4B/9B开源:亚秒级统一图像生成与编辑-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260119074104971-1768779664-7eb3698c9e99d94a9bc2e4fca73fcd9e.png)

开源地址

GitHub:https://github.com/black-forest-labs/flux2

ModelScope:

https://modelscope.cn/collections/black-forest-labs/FLUX-2-Klein

亚秒级推理速度 在现代硬件上,生成或编辑图像耗时低于0.5秒,大幅提升实时应用的响应速度。

- 统一生成与编辑架构 单一模型支持文生图(Text-to-Image)、图像编辑(Image-to-Image)和多参考图像生成,无需切换不同模型即可完成复杂的视觉任务。

- 消费级硬件友好 4B模型在RTX 3090/4070及以上显卡运行时仅占用约13GB显存,降低了开发和部署门槛。

- 高质量输出 在质量与延迟的帕累托前沿上表现优异,9B版本的性能可与5倍参数规模的模型匹敌。

- 完全开源与商业友好 4B系列采用Apache 2.0许可证,支持商业使用;9B系列采用FLUX非商业许可证,适用于研究和非商业场景。

- 量化加速支持 提供FP8和NVFP4量化版本,在RTX GPU上分别实现最高1.6倍和2.7倍的推理加速,显存占用分别降低40%和55%。

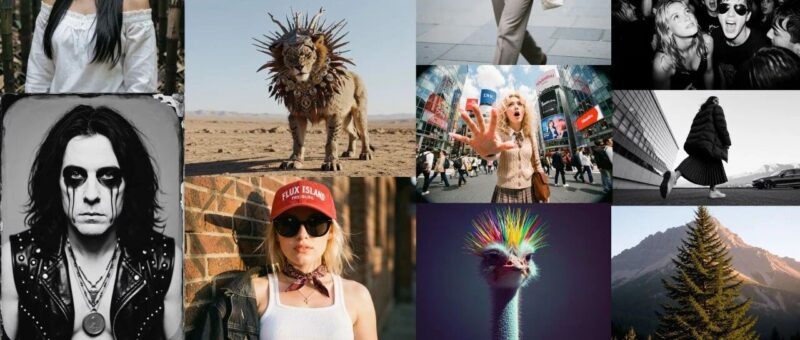

文生图效果

![图片[2]-FLUX.2-Klein 4B/9B开源:亚秒级统一图像生成与编辑-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260119074107421-1768779667-c1b7cda24509f3deadabb423d4ce7c72.png)

图片编辑效果

![图片[3]-FLUX.2-Klein 4B/9B开源:亚秒级统一图像生成与编辑-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260119074110139-1768779670-1fd2639afde5b48cd1f23b1074a8e2e7.png)

模型家族概览

FLUX.2 [klein]系列包含以下模型:

注:

- "klein"在德语中意为"小",反映了模型的紧凑规模和低延迟特性。

- 蒸馏版 vs Base版:

- 蒸馏版(9B/4B):经过步骤蒸馏优化至4步推理,速度更快,适合生产环境直接使用

- Base版(9B Base/4B Base):保留完整训练信号,输出多样性更高,适合微调和定制化开发

量化版本模型家族

本次开源同时发布了所有 [klein] 变体的 FP8 和 NVFP4 版本,这些版本是与 NVIDIA 合作开发的,旨在优化 RTX GPU 上的推理性能。功能相同,占用空间更小,并且兼容更多硬件。

- FP8版本:速度提升最高1.6倍,显存占用减少最高40%

- NVFP4版本:速度提升最高2.7倍,显存占用减少最高55%

注:在RTX 5080/5090上测试T2I,生成分辨率为1024×1024。

量化版本模型适用相同的许可证:4B 变体采用 Apache 2.0 许可证,9B 变体采用 FLUX NCL 许可证。

FLUX.2 [klein] 9B基于9B参数的流模型(Flow Model)构建,集成8B Qwen3文本编码器用于文本理解。通过步骤蒸馏(Step Distillation)技术,将推理步数压缩至4步,在保持高质量输出的同时大幅降低推理延迟。

模型采用统一架构处理多种视觉任务:

- 文生图:根据文本描述生成高质量图像

- 单参考编辑:基于单张参考图进行编辑和变换

- 多参考生成:结合多张输入图像,混合概念并生成复杂组合

Base版本保留了完整的训练信号,未经蒸馏处理,为微调、LoRA训练和自定义流程提供了最大的灵活性和控制能力。这种设计使得研究人员和开发者可以根据特定需求进行深度定制。

基准测试显示,FLUX.2 [klein]在Elo评分、推理延迟和显存占用三个维度上均实现了优异平衡:

- 在文生图、图生图单参考和多参考任务中,匹配或超越Qwen等同类模型的质量,延迟和显存占用仅为其一小部分

- 相比Z-Image,不仅质量更优,还在单一模型中支持文生图和多参考图像编辑

- GB200上bf16精度测试显示,蒸馏版在速度上显著领先,Base版在保持合理速度的同时提供了完整的定制能力

![图片[4]-FLUX.2-Klein 4B/9B开源:亚秒级统一图像生成与编辑-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260119074112515-1768779672-9c1948a0cdbff5591538c98b6d344028-scaled.png)

![图片[5]-FLUX.2-Klein 4B/9B开源:亚秒级统一图像生成与编辑-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260119074114568-1768779674-fa3e3ff0378cf841eda70b546502c79b-scaled.png)

模型下载

modelscope download --model black-forest-labs/FLUX.2-klein-9Bmodelscope download --model black-forest-labs/FLUX.2-klein-4B

环境安装

pip install -U diffusers 推理脚本

import torchfrom diffusers import Flux2KleinPipelinedevice = "cuda"dtype = torch.bfloat16pipe = Flux2KleinPipeline.from_pretrained("black-forest-labs/FLUX.2-klein-4B", torch_dtype=dtype)pipe.enable_model_cpu_offload() # save some VRAM by offloading the model to CPUprompt = "A cat holding a sign that says hello world"image = pipe(prompt,height=1024,width=1024,guidance_scale=1.0,num_inference_steps=4,generator=torch.Generator(device=device).manual_seed(0)).images[0]image.save("flux-klein.png")

显存占用

- FLUX.2 [klein] 4B:大约需要13GB,推荐NVIDIA RTX 3090/4070以上规格的显卡

- FLUX.2 [klein] 9B:大约需要29G存,推荐NVIDIA RTX 4090以上规格的显卡

FLUX.2 [klein]通过紧凑的架构和高效的推理能力,为实时视觉生成应用提供了新的可能性。模型在开源友好性、硬件要求和生成质量之间实现了良好平衡,适用于从本地开发到生产部署的多种场景。Base版本的完全开放为研究和定制化需求提供了充分的灵活性。

点击阅读原文,即可跳转模型合集~

<原文链接:https://mp.weixin.qq.com/s/Q-B8DTMhxcALWzpFHCLFyg

暂无评论内容