![图片[1]-Anthropic 再发长文:首次详细揭秘Agent的评估全过程「Claude code开发过程的经验总结」-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260112075022919-1768175422-f7b6cbbd45eae91ea12f8ebc2c2a675c.png)

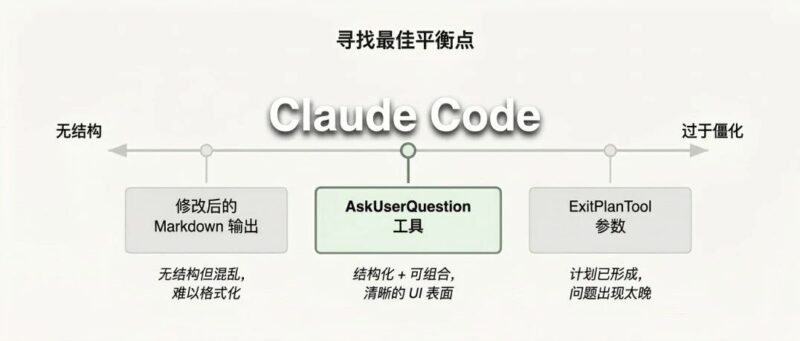

如何自信地发布AI Agent? 没有好的评估(Evals),团队很容易陷入“头痛医头、脚痛医脚”的被动循环——问题总是在生产环境中才暴露,修复一个bug又引发了新的问题。 评估,能在问题影响用户之前就将其可视化,其价值会在Agent的整个生命周期中不断累积。 Anthropic在自家明星产品Claude Code等Agent的开发过程中,以及与前沿客户的合作中,总结出了一套严谨且实用的AI Agent评估方法 这篇文章,就是对这些实战经验的全面梳理 原文: https://www.anthropic.com/engineering/demystifying-evals-for-ai-agents 一个“评估”(eval),本质上就是对AI系统的测试:给AI一个输入,然后用评分逻辑来衡量其输出是否成功。本文主要关注在开发阶段无需真实用户即可运行的自动化评估。 对于早期的LLM,单轮评估很直接:一个提示(prompt),一个响应,一套评分逻辑。但随着AI能力进化,多轮评估变得越来越普遍 Agent的评估则更为复杂。Agent会在多轮交互中使用工具,修改环境状态,并根据中间结果进行调整——这意味着错误会传播和累积。更重要的是,前沿模型能找到超越静态评估限制的创造性解决方案。例如,Opus 4.5在解决一个预订航班的测试问题时,通过发现政策漏洞,找到了一个对用户更好的方案,虽然它“失败”了评估,但实际上给出了更优解 在构建Agent评估时,Anthropic使用了以下定义: 在Agent开发初期,团队靠手动测试、内部试用和直觉就能走很远。但一旦Agent进入生产并开始规模化,没有评估的开发模式就会崩溃。 转折点通常是:用户反馈Agent在更新后“变差了”,而团队却“盲目飞行”,无法验证问题。调试变成被动响应:等待投诉、手动复现、修复bug,然后祈祷没有引入新的衰退(regression)。 Anthropic的Claude Code就经历了这一过程。初期依赖内外部用户的反馈快速迭代,后期加入了针对简洁性、文件编辑、过度工程化等复杂行为的评估。这些评估与生产监控、A/B测试、用户研究等方法相结合,为Claude Code的持续改进提供了关键信号。 无论是Descript(视频编辑Agent)还是Bolt AI,实践都证明了评估的价值: 评估的前期投入是可见的,但其复利价值会在后期逐渐显现。 Agent评估通常结合三种评分器:基于代码的、基于模型的和人工的 评分器类型 1. 基于代码的评分器 (Code-based graders) 2. 基于模型的评分器 (Model-based graders) 3. 人工评分器 (Human graders) 能力评估 vs. 衰退评估 当能力评估的通过率很高时,可以“毕业”成为一个衰退评估套件,持续运行以捕捉任何性能漂移。 1. 编码Agent 这类Agent编写、测试和调试代码。由于软件评估标准明确(代码能跑吗?测试通过吗?),确定性评分器是自然的选择。 示例:一个修复认证漏洞的编码任务评估配置(YAML格式) 在实践中,通常以单元测试验证正确性,LLM评分规则评估代码质量为主。 2. 对话Agent 这类Agent(如客服、销售)的挑战在于,交互质量本身就是评估的一部分。评估通常依赖可验证的最终状态和评估交互质量的规则。一个独特之处是,它们常需要另一个LLM来模拟用户。 3. 研究Agent 这类Agent负责收集、综合和分析信息。评估的挑战在于“全面”、“来源可靠”甚至“正确”都是上下文相关的,且基准信息(ground truth)会不断变化。 4. 计算机使用Agent 这类Agent通过GUI(截图、鼠标点击、键盘输入)与软件交互,而非API。评估需要在真实或沙盒化的环境中运行Agent。 Agent的行为在每次运行时都可能不同,这使得评估结果的解读变得复杂。 两个指标有助于捕捉这种细微差别: 在k=1时,两者相等。但随着k增加,两者会迅速分化。选择哪个指标取决于产品需求: 第一阶段:收集初始评估数据集 第二阶段:设计评估框架和评分器 第三阶段:长期维护和使用评估 自动化评估只是理解Agent性能的多种方法之一。一个完整的图景还应包括: 这些方法如同安全工程中的“瑞士奶酪模型”,没有任何一层能捕捉所有问题。但将它们组合起来,一层遗漏的失败会被另一层捕捉到。最有效的团队会将这些方法结合使用。 没有评估的团队会陷入被动修复的泥潭。而尽早投入评估的团队则会发现开发速度在加快,因为失败案例变成了测试用例,测试用例防止了衰退,而指标取代了猜测。 尽管不同类型Agent的评估模式各异,但本文描述的基本原则是通用的:尽早开始,从真实失败中获取任务,定义明确的成功标准,深思熟虑地设计评分器,并坚持阅读记录。 AI Agent评估是一个新兴且快速发展的领域。随着Agent承担更长、更主观、更需要协作的任务,我们的技术也需要不断演进 source: https://www.anthropic.com/engineering/demystifying-evals-for-ai-agents![图片[2]-Anthropic 再发长文:首次详细揭秘Agent的评估全过程「Claude code开发过程的经验总结」-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260112075024554-1768175424-d41567bf150159526078f1c92756df9e.png)

评估的基本结构

![图片[3]-Anthropic 再发长文:首次详细揭秘Agent的评估全过程「Claude code开发过程的经验总结」-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260112075025470-1768175425-2553bbeb3e3375d1be30860be5760ddc.png)

![图片[4]-Anthropic 再发长文:首次详细揭秘Agent的评估全过程「Claude code开发过程的经验总结」-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260112075025782-1768175425-a5b5bc9d9cbd67a8e9a5715cc261dd75.png)

为什么要构建评估?

如何评估AI Agent?

![图片[5]-Anthropic 再发长文:首次详细揭秘Agent的评估全过程「Claude code开发过程的经验总结」-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260112075026709-1768175426-6bc06d968e47f66b9f1aedb777b90132.png)

![图片[6]-Anthropic 再发长文:首次详细揭秘Agent的评估全过程「Claude code开发过程的经验总结」-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260112075027342-1768175427-e8cbc6de620d98324ab6a17f09904475.png)

![图片[7]-Anthropic 再发长文:首次详细揭秘Agent的评估全过程「Claude code开发过程的经验总结」-AI Express News](https://www.aiexpress.news/wp-content/uploads/2026/01/20260112075028928-1768175428-fef40f07d29b93e46b2639bdadf9cfe9.png)

针对不同类型Agent的评估方法

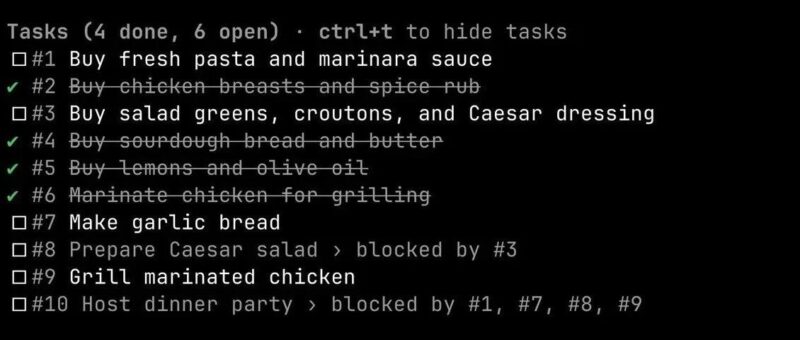

task:

id: "fix-auth-bypass_1"

desc: "修复当密码字段为空时的认证绕过问题..."

graders:

- type: deterministic_tests # 确定性测试

required: [test_empty_pw_rejected.py, test_null_pw_rejected.py]

- type: llm_rubric # LLM评分

rubric: prompts/code_quality.md

- type: static_analysis # 静态分析

commands: [ruff, mypy, bandit]

- type: state_check # 状态检查

expect:

security_logs: {event_type: "auth_blocked"}

- type: tool_calls # 工具调用检查

required:

- {tool: read_file, params: {path: "src/auth/*"}}

- {tool: edit_file}

- {tool: run_tests}

tracked_metrics:

- type: transcript # 记录指标

metrics: [n_turns, n_toolcalls, n_total_tokens]

- type: latency # 延迟指标

metrics: [time_to_first_token, output_tokens_per_sec, time_to_last_token]如何看待评估中的不确定性?

pass@k关注“找到解”,pass^k关注“稳定性”。从0到1:构建优秀Agent评估的路线图

评估如何与其他方法协同?

自动化评估 生产监控 A/B测试 用户反馈 人工记录审查 系统化人类研究 结论

--end--

<原文链接:https://mp.weixin.qq.com/s/XAagCdKLqj47z-9kwTaqHg

暂无评论内容