![图片[1]-英伟达机器人掌门人Jim Fan年度复盘:Vibe Coding火出圈,机器人领域却依然焦头烂额-AI Express News](https://www.aiexpress.news/wp-content/uploads/2025/12/20251230083432730-1767054872-c0c765aee4c2d42d8c31b84a111cbf1b.png)

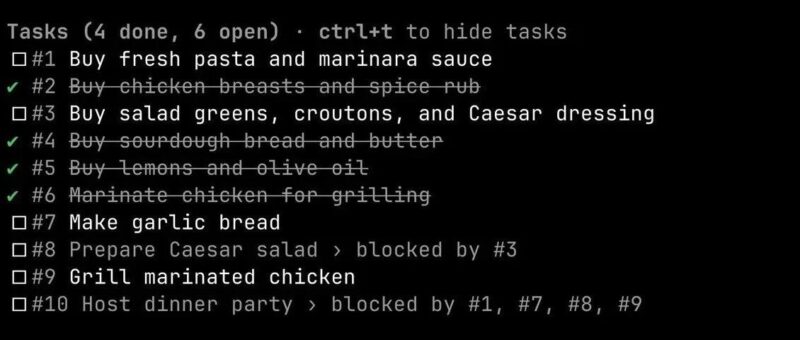

AK这两天发了一篇推文,引爆了媒体,因为Vibe Coding真的太厉害了,厉害到连AK都焦虑了,AK认为过去一个月没有跟上节奏的人已经对软件行业的认知out了,感兴趣的可以看我的文章软件行业正在发生9级大地震!Andrej Karpathy也感到焦虑了:他从未感觉如此落伍 与此同时,2025年的机器人领域发展可能是另一番景象,英伟达机器人业务负责人、GEAR实验室联合负责人Jim Fan泼了一盆冷水,jim fan 认为机器人领域还处于混乱状态,就连发展方向都有可能是错的 Jim Fan刚刚分享了他对机器人领域现状的焦虑,这是他在2025年学到的3个教训 我们已经见证了精湛的工程艺术,比如Optimus、e-Atlas、Figure、Neo、G1等等。 现状是,身体的能力超过了大脑的指挥能力,我们要用到最好的AI,并没有榨干这些前沿硬件的全部汁水 然而,照看这些机器人需要整整一个运营团队 不像人类,机器人没法从瘀伤中自愈。过热、电机损坏、离奇的固件问题每天都在困扰着我们。错误是不可逆的,也是不可原谅的 Jim Fan感叹:唯一能随着规模增长的,只有我的耐心 LLM圈的普通人以为MMLU和SWE-Bench是常识。但在机器人领域?先别急。 在这里,没有人对任何事情达成一致:无论是硬件平台、任务定义、评分标准、模拟器,还是现实世界的设置 每个人都在针对每个新闻发布临时定义的基准测试上,宣称自己是SOTA(当前最佳)。每个人都从100次重试中,挑樱桃般选出看起来最漂亮的那一次演示。 Jim Fan呼吁:2026年我们必须做得更好,停止将可复现性和科学纪律视为二等公民 VLA(视觉-语言-动作)模型一直是机器人大脑的主流方法。配方很简单:拿一个预训练的VLM(视觉语言模型)检查点,在上面嫁接一个动作模块。 但仔细想想,VLM是为“视觉问答”这类Benchmark高度优化的。 这意味着两个问题: 1.VLM中的大多数参数是为语言和知识服务的,而不是为物理学服务的; 但微小的细节对灵巧性至关重要。 Jim Fan认为,没有理由相信VLA的性能会随着VLM参数的增加而扩展。预训练是错位的 相比之下,视觉世界模型(Video World Model)似乎是机器人策略更好的预训练目标。Jim Fan表示正在押注于此 质疑与回应 针对Jim Fan的观点,网友Stewart Alsop提出了尖锐的质疑: 如果视频世界模型是更好的预训练目标,为什么Helix、GR00T N1和π0这些真正交付结果的模型,依然构建在VLM骨干之上? 世界模型的方法目前大多只用于策略评估和合成数据,而非直接的运动控制。 另外,既然硬件瓶颈限制了迭代速度,这难道不适用于任何预训练路线吗?直到我们解决机器人数据缺口之前 Jim Fan: 它们是2025年的模型,期待2026年的下一个大模型 我个人认为2026年还是要看谷歌,DeepMind还在憋大招,8月份时已经展示过Genie 3这个强大的世界模型了,Genie 4有可能真正让机器人拥有在现实世界连续执行任务的大脑![图片[2]-英伟达机器人掌门人Jim Fan年度复盘:Vibe Coding火出圈,机器人领域却依然焦头烂额-AI Express News](https://www.aiexpress.news/wp-content/uploads/2025/12/20251230083433418-1767054873-05c164027f9a74cee0172f43ba0a76f3.png)

1. 硬件虽领先软件,但可靠性严重拖累迭代速度

2. Benchmark在机器人领域仍是一场灾难

3. 基于VLM的VLA路线「感觉不对」

2.视觉编码器为了高层理解(Q&A),会主动调整以丢弃低级细节。

--end--

<原文链接:https://mp.weixin.qq.com/s/XPo9svdjsNVQ8r6lV4Yp_w

暂无评论内容