![图片[1]-喝点VC|a16z的未来展望:现在AI不是泡沫,因为它还没破裂;只有当投入打水漂,才能确认它曾经是泡沫-AI Express News](https://www.aiexpress.news/wp-content/uploads/2025/12/20251219082018979-1766103618-0d23d9b7f2cef136a7f7fd053a8c9a07.png)

图片来源:a16z

Z Highlights

目前来看,企业实际赚到的利润情况其实非常好。如果他们停止开发更大规模的模型,只靠现有的模型运营,按照当前的利润率,很快就能实现盈利。从这个角度来说,现在确实不像是泡沫。

总有人说AI还没盈利,企业还在持续投入以求盈利。但实际上,他们很快就能收回过去所有的开发成本了。现在的投入,只是为了未来的进一步发展。

要推进研发,必须进行更多实验,这也就意味着纯软件奇点很难实现

在高端市场,我肯定会预期有新的工作岗位被创造出来。每个人依然可以成为影响者。但在高端领域,确实很难指出哪些具体工作是AI目前绝对无法自动化的。

单纯砸钱并不会让基准测试变得更好,但平均来说,开发更高级的基准测试确实需要投入更多资源

a16z:全称Andreessen Horowitz,是一家美国私人风险投资公司,由马克·安德里森和本·霍罗威茨于2009年创立。该公司总部位于美国加利福尼亚州门洛帕克。安德里森·霍罗威茨投资于早期新创公司和已成熟的成长型公司。其投资范围涵盖医疗保健、消费者、加密货币、游戏、金融科技、教育以及企业信息技术等产业。

AI泡沫争议——投入、价值与盈利的核心讨论

Erik Torenberg:各位,关于AI的宏观讨论有很多。我们现在正处于泡沫之中吗?该怎么看待这个问题?后面我们会聊预测相关的话题,不过现在不妨先说说,该如何着手分析这么宽泛的问题。

David Owen:对我来说,思考这个问题的核心是看一个关键指标,比如大家在算力等方面的投入情况。另外还要考虑,这些投入之后会不会让人后悔。至于投入规模,看看英伟达每年的销售额就知道了,目前是持续增长的,情况还算不错。但要说会不会后悔,这就只能靠猜了,还得慢慢观察。现在大部分算力都用在推理上,企业用这些算力提供服务,目前看来并没有后悔的意思。所以单从这一点来说,我觉得还不算太泡沫。不过我也不敢太确定,还有其他因素需要考量。

Yafah Edelman:目前来看,企业实际赚到的利润情况其实非常好。如果他们停止开发更大规模的模型,只靠现有的模型运营,按照当前的利润率,很快就能实现盈利。从这个角度来说,现在确实不像是泡沫。但另一方面,企业一直在投入资金构建更庞大的模型。要是顺利,利润会更可观;可如果不顺利,就算现在盈利再多,跟投入的成本比起来也只是小数目。所以从财务数据来看,目前并没有迹象表明存在泡沫。很多担心泡沫的人,可能是不习惯现在这么大的投入规模,也没适应AI已经取得的成功和扩张速度。但如果真的存在泡沫,它可能会突然破裂,而且后果会相当严重。

David Owen:其实我们差不多能给你一个明确的答案:我觉得现在不是泡沫,因为它还没破。泡沫这东西,只有破了之后你才能确定它是泡沫。

Yafah Edelman:总有人说AI还没盈利,企业还在持续投入以求盈利。但实际上,他们很快就能收回过去所有的开发成本了。现在的投入,只是为了未来的进一步发展。所以我认为,至少目前AI有潜在的盈利能力,要是说现在有明显的泡沫,那反而有点出人意料。

David Owen:大家在这些AI模型上花了不少钱,用户也在实际使用。他们愿意花钱,可能是因为确实从中获得了价值。你可能会说这种价值不真实,大家只是拿来玩玩而已,但不管背后的原因是什么,用户愿意付费这个现象,本身就是个相当可靠的信号。

Erik Torenberg:没错,大家在这些模型上投入巨大,愿意花钱肯定是因为从中得到了价值。你可能会反驳说,这种价值不是真实的,只是大家图个新鲜,但不管付费原因是什么,这都是个很有说服力的信号。我们其实已经能给出一个还算靠谱的答案了:这不是泡沫,因为它还没破裂。只有当投入打水漂、泡沫破裂之后,我们才能确认它曾经是泡沫。

Yafah Edelman:总有人说AI还没盈利,企业还在不断投入以求盈利。但实际上,他们很快就能收回过去所有的开发成本了,现在的投入只是为了未来的进一步发展。

David Owen:他们会不会后悔这些投入呢?投入规模到底有多大?看看每年的销售额就知道了,目前是持续增长的,情况还不错。

Yafah Edelman:说实话,导航这类任务对AI来说其实特别简单。大家总说这需要AI达到极高的智能水平,但实际做起来就像创作艺术品一样,AI的表现远比人们预想的要好。

David Owen:几十年前的国际象棋就是这样,对吧?当时计算机成功攻克了国际象棋,大家都觉得这是推理能力的巅峰。结果等计算机真的做到了之后,人们又觉得,计算机能下棋也没什么大不了的。

技术演进:预训练趋势、纯软件奇点与模型能力边界

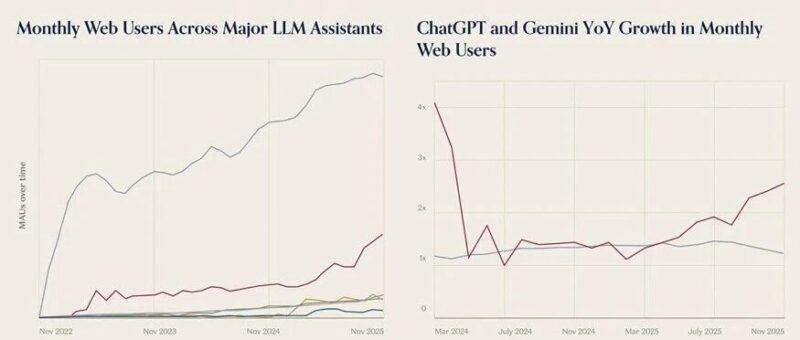

Yafah Edelman:有个相关的问题想问问你,你之前提到了2030年AI报告,里面说没看到模型能力停滞的迹象,反而一直在提升,而且有基准测试支撑,数据量和算力也在持续增长。那你觉得模型在某些方面会不会已经出现停滞了?比如预训练技术。我们现在看到的是停滞,还是说大家还在不断探索创新?你怎么看?

David Owen:这一点其实很难判断,因为我们现在进入了一个缺乏公开数据的领域。预训练确实不像以前那样是唯一的焦点了,部分原因是出现了后训练这个新方向,大家在推理等方面做了很多工作。但这并不意味着预训练就无法进一步扩展了。目前看来,还有很多未被利用的数据,而且这些技术之间很可能是协同作用的:先开发出更好的模型,再通过后训练技术优化,然后从模型的实际使用中获取大量数据——不管是成功的还是失败的案例,其中很多都能用于下一轮预训练。

Erik Torenberg:你们没有预测纯软件奇点的出现,也就是AI能够自动化AI研究,形成自我改进的反馈循环。为什么会这样呢?

David Owen:这份报告并不是个人预测,它主要是审视当前的趋势,看看有没有明显的理由表明这些趋势无法持续。如果趋势能持续,又会导向什么结果?我觉得,这种自我改进的情况,很难通过现有趋势去推断。目前AI确实能在一定程度上辅助研发工作,比如编码或者选择数据集之类的。但这种辅助作用很难量化,而且也没有达到自我改进所暗示的那种显著效果。有理由认为,要实现完全的自动化研发其实非常困难。大家也讨论过,如果技术进展很大程度上依赖于算力的扩大,那么自动化研发能起到的作用可能就很有限。我觉得这种说法有一定道理,但也不能完全确定,毕竟这种超出常规的情况太难推测了。

Yafah Edelman:纯软件奇点要出现,有一个必要条件:必须处于这样一个世界——仅仅依靠增加研发人员的工作时间,就能改进AI,从而弥补无法扩展实验算力或预训练规模的不足。如果真是这样,那我们应该会看到,实际使用的实验算力并不多,所有资金都流向了研究人员。但目前的情况是,虽然有大量资金投入到研究人员身上,但据我们所知,实验算力的投入规模也不相上下,甚至比最终发布模型的训练运行所投入的资金还要多很多倍。这一点让我改变了之前的看法——大规模实验其实是研发的必要条件。我们没有足够的证据表明,只靠研究人员,不做更多实验,就能加速技术进展。不过这方面也有很多不同的观点,都有各自的道理。我个人倾向于认为,要推进研发,必须进行更多实验,这也就意味着纯软件奇点很难实现。但我并不觉得持相反观点的人是错的,他们的想法也有合理之处,毕竟我们现在都是在猜测一个数据很匮乏的领域。说到这里,我又想到一个问题。有些公司的研究人员在尝试探索超出可验证的领域,比如有观点认为,梯度下降在当前的数据集上学习效果很好,但如果反复训练,模型会开始忘记之前学过的内容,也就是所谓的“灾难性遗忘”。你怎么看待这个观点?孩子们学习可不是这样的。也许孩子们是通过模仿学习,也可能是通过某种探索的方式学习。我很好奇你的看法。如果孩子真的只靠模仿就能学习,那抚养孩子就简单多了。但抚养孩子之所以难,似乎就是因为他们会去探索各种各样的东西。那么在算法改进方面,除了数据和算力,我们还需要什么才能持续优化这些模型呢?

Yafah Edelman:我不太愿意把AI学习和人类学习放在一起比较。不是说两者完全不能比,而是因为我们现在对AI学习的了解,远比对人类学习的了解要多。人们总爱对人类的学习方式做各种假设,然后说AI不是这么学习的。我不知道这种说法是不是真的,也许人类孩子确实是通过强化学习来成长的。我对这一点没有强烈的立场,但我觉得,人们总会找到利用现有算力的方法,毕竟过去他们一直都是这么做的。

David Owen:我也不太倾向于做这种比较。就拿你说的灾难性遗忘来说,随着模型规模的扩大,我们在这方面其实已经做得越来越好了,模型能记住的东西也越来越多。这并不是说这个问题已经完全解决了,不需要再创新了,只是我也不会完全否定当前的技术路径。

Yafah Edelman:我绝对不认为这些担忧已经导致模型能力的增长放缓了。人们总会有各种各样的担忧,但在这些担忧真正反映到实际数据之前,我是不会轻易相信的。

AI与编码:预测争议、效率衡量与实际影响

Erik Torenberg:Anthropic的Dario在2025年3月说过,六个月内AI将编写90%的代码,当然这个预测现在还没实现。他还说,我们可能在2026或2027年拥有相当于一个“天才国家”的AI系统。你们怎么看待Anthropic的这种乐观态度?你们和他们的核心分歧在哪里?

David Owen:我的理解是,他们更相信自动化研发能带来技术的快速突破。他们认为,我们现在开发的AI非常适合研究工程类的编码工作,等这些AI足够好用之后,会迅速加速下一代模型的开发,到时候技术进展就会变得非常快。

Yafah Edelman:这很难判断。就我所知,我们没有足够的证据证明纯软件快速突破的观点是错误的,只是AI要达到最低必要能力水平,所需要的时间可能比他们预测的要长一些。但这也只是我的猜测。Dario说话的时候经常会用“最早”之类的词来限定,所以他给出的可能是一个比较乐观的时间线,我也不确定。

David Owen:还有些人会像解读塔木德一样,仔细抠他的措辞,还会讨论Anthropic团队生成的代码行数是否符合他的说法。所以这件事其实挺棘手的,没有一个明确的判断标准。

Yafah Edelman:我记得Uplift论文说模型的效率实际上会变慢,但这很大程度上取决于他们当时使用的模型——那份报告出来的时候,那些模型已经相当过时了。以我个人的经验来看,AI确实能让工作效率大幅提升。仅仅是能掌握整个代码库的上下文,就是一个巨大的优势,这一点人类很难做到。现在我写的代码里,超过90%都是AI完成的,但我很清楚自己不是普通的程序员。不过我觉得,现在预测AI将编写90%的代码,也不算完全离谱。据我所知,在OpenAI或者其他地方,可能已经有人在用AlphaCode通过进化算法做大量试验,试图解决一些难题。目前到底有多少代码是AI编写的,其实很难说清楚。很多人直觉上会觉得“程序员90%的工作都被AI替代了?肯定没有”,但实际情况要复杂得多。

David Owen:这确实是个很关键的区别。如果只看通过Tab补全等方式“编写”的代码行数,比例可能确实很高,但这并不意味着AI承担了程序员最核心、最困难的工作。你提到的Uplift论文很有意思,也很有价值,而且出人意料地新。你说里面的模型过时了,但那是2025年初的研究,当时大家确实觉得那些模型是有帮助的。论文里提到,参与者一开始就预测会提速,事后也表示确实提速了。这说明,我们可能真的很难准确判断AI到底有没有提升工作效率。

Yafah Edelman:可能出现的情况是,很多AI编写的代码,其实是人类原本不会去写的。所以它并不是加速了原本就会发生的开发工作,而是创造了一些新的代码。比如我现在运行的很多简单图表或模拟程序,要是没有AI,我可能根本不会去写。因此很难确切衡量AI在编码领域的实际影响。我觉得最终最可靠的指标,还是看这些AI公司从程序员用户和订阅服务中赚了多少钱——他们现在赚得不少,这说明大家确实在使用这些工具,而且很可能有相当一部分是用于编码的,只是并不完全符合“完成现有程序员90%工作”的那种预期。

劳动力市场:十年变革、失业率风险与职业存续

Erik Torenberg:生物学里有个说法经常被引用:AI是“端到端”的,但更是“中间到中间”的。这意思是说,我们可能需要比想象中更多的人力参与。你们对AI未来十年在低端和高端劳动力市场的作用,有什么样的思考框架?

Yafah Edelman:未来十年吗?在高端市场,我肯定会预期有新的工作岗位被创造出来。每个人依然可以成为影响者。但在高端领域,确实很难指出哪些具体工作是AI目前绝对无法自动化的。你可以说存在一些未知的情况,这一点我也认同。但AI总会遇到各种极限,而我们找出这些极限后,它又会继续学习、不断突破。所以在高端市场,AI很可能会自动化几乎所有现有的工作,除了那些人们坚持要由人类来完成的体力劳动。这对我来说并非完全不可能,甚至可能发生得非常快。不过要注意的是,如果真的出现这种情况,可能会遇到监管方面的阻力。而在低端市场,我就不确定了——AI可能只是一场泡沫,不会产生任何实际影响。我之前提到过一个有意思的设想,大概有20%到30%的概率会发生:在很短的时间内,比如六个月,因为AI的某些新应用或新发布,导致失业率上升5%。我认为这会对世界产生实质性的影响,不管是人们对AI的看法,还是AI受到的关注度,都会发生巨大变化。这个设想在我看来是合理的,但远不是确定的。

David Owen:我非常同意“高度不确定”这一点。在我看来,我们这代人很可能恰好遇到AI进展停滞的情况。这听起来很疯狂,但确实有可能发生。如果真是这样,那AI相关的工作就只会变成技术人员的专属,他们需要把AI整合到现有的工作流程中,做一些有用但相对粗糙的应用。当然,也有可能出现失控的情况,AI真的自动化大量工作。我的时间线可能比“停滞论”要长一些,但很难排除十年内发生重大变革的可能——毕竟十年的时间可不短。

Yafah Edelman:如果未来十年内,现有工作中没有被AI自动化的比例低于5%,我会感到惊讶。说实话,就算低于10%,我也觉得意外。至于这种自动化会发生得有多快,被替代的人能不能找到新工作,我没有看到令人信服的证据,这可能取决于技术进展的速度,以及具体哪些工作会被自动化。我认为,未来十年内10%的现有工作被AI替代,是一个相当合理的下限。这不是我认为的最低值,但确实是一个比较靠谱的数字。不过这一点可能不会体现在总体失业率上。

David Owen:这很有意思。主流经济学观点可能是这样的:自动化发生在任务层面,而不是整个职业层面。所以虽然职业数量可能会大幅减少,但很多时候,AI自动化的只是不同工作中类似的任务。我觉得这个观点和你的说法是兼容的,只是有些工作会受到更严重的冲击。这个问题确实很难深入思考。我不确定职业存续的历史基准率是多少。我知道这里存在一些问题,比如在历史就业数据中,工作任务的变化、职业本身的兴衰更替,其实是很常见的,基准率相当高。所以就算是5%的工作被替代,我也不知道该怎么判断——这到底是一个巨大的冲击,还是和软件行业曾经带来的影响差不多?我也说不准。

Yafah Edelman:软件出现后,有5%的原有工作消失了,这似乎是合理的,但我对此并没有十足的把握。不过我预期,尤其是如果AI的收入趋势能持续下去,一两年内,可能明年,我们就能更清楚地看到答案了。因为到那个时候,AI行业赚取的收入将成为经济的重要组成部分。如果这没有体现在失业率上,我们就能知道AI在做什么——它能在不影响就业的情况下发挥作用;如果影响了失业率,我们也能看到具体的情况。目前已经有一些早期研究在关注这方面的指标了。研究这个问题其实有很多复杂因素。比如利率会影响经济状况,正常的人员流动也会干扰数据。还有可能出现这样的情况:科技公司为了筹集资金建设数据中心,解雇大量程序员。这些程序员失业,真的是因为AI吗?我不知道,也许是,也许不是。

专业选择建议:通用能力优先,拒绝短期热门

Erik Torenberg:如果你有一个刚上大学的晚辈,问你“我应该主修什么才能有好的职业发展?”,针对计算机科学或数学这些专业,你会怎么建议?

Yafah Edelman:你会怎么说?我大概会告诉他,不要主修提示工程。毕竟现在使用AI变得越来越容易了,专门学这个没必要。

Yafah Edelman:这确实是个好问题。如果他们打算主修编程或计算机科学,那目标不应该是成为只懂编程语言的技术人员。真正有用的是那些更通用的技能,比如与人合作的能力、沟通技巧等等。我不太确定这是否指向某个特定的专业——大多数专业其实和未来的工作都没有直接的对应关系。

David Owen:我大概会说,你很难为一个变化莫测的未来做太多规划,所以不如选择自己热爱且对世界有价值的领域,不用太追求潮流。这样来看,计算机科学、数学这些专业其实很好,如果你真的喜欢它们,那它们在很多场景下都有价值。不过我也说不准,我最近给一个年轻亲戚提建议,他最后选择了学习戏剧。

Yafah Edelman:我觉得,大学四年是人生中很重要的一段时光,过得开心才是最重要的。说到底,很难说哪条路最终能让你未来更快乐,为当下做好规划反而更容易。现在确实很难预测未来,对吧?我记得提示工程师两年前还被很多人看好,大家都觉得这是个有前景的职业,现在看来显然是个笑话。因为模型在提示交互方面已经进步太多了。所以随着模型不断改进,真的没人能说准未来会发生什么。

计算机使用与基准测试:当前局限与未来方向

Yafah Edelman:我有个相关的问题:编码是一个巨大的市场,影响也很大,但还有一个领域让我非常兴奋,而且我觉得还处于早期阶段,那就是计算机使用——也就是自动化你在计算机上完成的所有数字任务。这方面的基准测试非常少。你在报告中也谈到了基准测试的局限性。你认为这个领域缺少什么?为什么我们没有看到像Sonnet3.5、ClaudeCode或Codex发布时那样,在编码能力上出现显著提升的时刻?你觉得问题出在哪里?

David Owen:这个问题很有意思。计算机使用方面确实有进步。也许我的想法有点大胆,但我觉得模型在视觉能力上受到了人为限制。当你试图让模型操作图形用户界面(GUI)时,常见的情况是它会变得很困惑,操作起来杂乱无章。这和它在复杂编码问题中容易陷入困境的情况有点像,但更严重——因为你很难回溯找到问题所在,它只会陷入反复点击的死循环。我觉得这是其中一个原因。另外可能还有长上下文连贯性的问题:代表图形用户界面的标记(token)相当大,随着操作的推进,上下文窗口会被“之前发生的所有事情”占满,导致模型的输出越来越不合理。我觉得这是两个主要问题,不知道是不是回答了你的疑问。

Yafah Edelman:我发现计算机使用……今年是我第一次觉得它真的有用。我们在做数据中心研究的时候,会用到ChatGPT智能体,因为我们需要查找各种许可证,而这些许可证都存放在各州、各县那些设计得很糟糕的数据库里。我不知道美国每个县都有哪些数据库,普通的ChatGPT也无法搜索这些数据库,因为它们是实际的用户界面,不能只靠网址搜索。但ChatGPT智能体能够导航这些界面,我只需要让它查找某个城市数据中心的许可证,它就能返回空气污染许可证、税收减免文件等所有相关资料,让我学到了很多。这都是过去一年左右计算机使用功能改进带来的结果。我对此非常兴奋,觉得它会变得越来越好,而且现在已经开始发挥作用了。

经济影响:GDP预测、AGI效应与增长模型

Erik Torenberg:你们对生产力或整体经济数据的变化有更全面的思考框架吗?有人说GDP增长会达到5%(我记得这是DollarAccount的观点),也有人说如果真的实现了AGI(通用人工智能),增长率应该能达到10%甚至更高。你们对生产力变化有什么样的预测模型?

David Owen:我的基本猜测是,如果收入保持当前的趋势,理论上来说,花这么多钱购买芯片用于推理是值得的,也应该能获得相应的价值回报。因此可以推断,到2030年……我在报告中计算过,大概会有几个百分点的GDP增长。这并不是假设AGI已经实现,而是基于英伟达收入保持之前的增长速度,并且算力等资源也能同步提升的前提。至于AGI,不同人对它的定义不一样。如果你真的能得到一个可以远程完成人类任何任务的AI,那么经济很可能会出现大幅增长。但很难准确猜测这个增长会有多长的滞后期。有理由认为,人们接受新事物的速度可能很慢——大家需要时间学会信任AI。但也有相反的理由:现在很多人已经在使用这些技术了。很多技术的普及速度可能比大多数图表显示的要快,比如LLM(大型语言模型)的采用速度就比之前很多技术都要快。所以到那个时候,建模就会变得很困难。我们网站上有一些粗略的估算,比如如果虚拟劳动力翻倍或者增长十倍,会带来什么样的影响?结果会是GDP出现惊人的增长。我不知道这是不是最合理的思考方式,很大程度上取决于你想象中的AI是什么样的——是真的无所不能,还是只能先完成一部分有意义的远程任务,而明年还无法胜任一整个类别的工作。所以回到问题本身,根据当前的趋势,我最合理的猜测是,到2030年GDP会增长几个百分点,这按经济标准来说已经很惊人了;但如果再做更长远的预测,比如AGI实现后的情况,那结果就太疯狂了,我不太愿意做这样的预测。

Yafah Edelman:我可能会更敢于预测一些。假设未来十年我们能获得一个可以像人类一样完成任何远程工作的AI,我认为30%的GDP增长是一个合理的下限。这是一个很大胆的假设,很多人会不同意,但如果真的发生了,我觉得结果要么是30%的GDP增长,要么就是人类灭绝导致GDP归零。归根结底,拥有这样的AI意味着技术具备可扩展性,而如果技术可扩展,就很可能会进一步升级。目前我看到的经济模型显示,如果AI能完全替代人类工作,实现自动化,那么要么会出现极快的爆发式增长,要么……有些人做模型时会假设当前的技术水平,比如AI能力和GPT-3相当,所以得出的增长数字会比较小。我觉得那些较低的增长预测,要么是短期的,要么就是没有考虑到未来十年AI可能达到的能力上限。

David Owen:确实很难想象,一个拥有能胜任人类所有工作的虚拟劳动力的世界,不会出现极端的结果。我完全同意这一点。也许会有……我不知道……严格监管的情况来避免极端结果,但也只是也许。

Yafah Edelman:但那些被严格监管的世界,其实并不是稳定的长期状态。不过也不是完全不可能。默认情况下,结果很可能要么是疯狂增长,要么是彻底崩溃。如果你进入一个AI真的能像人类一样做好任何工作的世界,却声称不会发生任何极端变化,那才是疯狂的。AI能做的事情太多了,它应该会从根本上改变经济的走向,要么向好,要么向坏。

David Owen:我的直觉是,很多分歧……可能部分源于人们固有的信念,但也有部分原因是,当大家谈论“能完成远程工作的AGI”时,虽然感觉在说同一件事,但实际上可能理解并不一样。我肯定有过这样的对话:有人说AI能做任何远程工作,但接着又会讨论它做不了的事情,而那些事情其实也是人类目前正在做的远程工作。所以我觉得这种理解上的偏差是存在的。

基准测试与模型衡量:现有局限与未来方向

Yafah Edelman:你怎么看?你在报告中谈到了基准测试,但我想知道,到2027、2028年,衡量AI进展的正确基准测试会是什么?不仅仅是经济增长,更重要的是模型的能力和智能水平。2012年我们有AlexNet,显然这个模型早就被超越了,而且它绝对不能作为衡量AGI的标准。你认为现在的基准测试,比如MMLU、GPQA,会不会也遭遇同样的命运?假设我们在这些基准测试中都拿到了满分,之后该用什么来衡量AI的进步?是看模型带来的GDP增长,还是看它实现的科学突破?你觉得正确的衡量方式是什么?

David Owen:是的,我认为我们现在大部分的基准测试很快就会被AI攻克。你举的MMLU、GPQA这两个例子,已经非常接近被完全解决了。MMLU基本上已经被攻克了,GPQA可能还差一点,具体取决于一些问题的模糊程度。细节上还有提升空间,但真的快了。我觉得未来的方向很明确:开发更难、更好、更贴近现实场景的基准测试。现在已经有人在这么做了。

David Owen:会有更难的软件基准测试出现,大家会更用心地设计这些测试,覆盖更广泛的任务。比如,这可能还涉及到预算问题。显然,单纯砸钱并不会让基准测试变得更好,但平均来说,开发更高级的基准测试确实需要投入更多资源。如果你想以更高的标准来证明AI的高级能力,那么在开发基准测试时就需要付出更多努力。但我确实认为,未来会出现一些虽然数量不多,但非常令人印象深刻的案例。这些案例本身就是很有价值的信号,比如当你看到AI能够重构整个代码库,而且真的有用时,这就是一个强有力的证据。即使这些案例还没有被正式化为基准测试,但只要你亲眼看到了,对你来说就是有用的证据。之后人们可能会围绕这些案例设计基准测试,让衡量方式变得更系统化。

未来里程碑:数学突破、医学进展与超级智能

Erik Torenberg:我想回到时间线的问题,问问你们对几个不同里程碑的看法。首先,AI解决一个尚未解决的主要数学问题,大概会在什么时候?

David Owen:你得先明确几个定义。你说的“解决”,是指AI完全独立完成,还是说有新闻报道或者有人发推文说“我把问题丢给GPT,它就解决了”?还有,什么才算“主要”数学问题?

Erik Torenberg:是我们都认可的、有实质性意义的问题,而不仅仅是传闻。

David Owen:必须是独立解决的?

Erik Torenberg:对,就按这个标准来。

David Owen:好的。其实已经有一些案例了,虽然还存在争议,但有可信的数学家表示,AI在他们的证明过程中提供了很大的帮助。

Yafah Edelman:如果AI在未来五年内解决了像黎曼猜想这样的重大未解决数学问题,我不会感到惊讶。我不敢说这是最有可能发生的情况,但绝对不会觉得意外。目前来看,数学对AI来说似乎并不难。有些事情确实很难,但数学领域显然不是AI的短板——AI在数学领域的表现相当出色,甚至在大多数其他领域还没达到能给正教授提供有效帮助的水平时,在数学领域已经接近或达到了。而且,AI一些异常突出的能力,实际上可能在解决数学问题时非常有用。比如,也许AI知道四篇包含晦涩结论的论文,而这些结论结合起来就能解决某个重大猜想。这种事情,AI做起来可能比人类容易得多。当然这里面有很多不确定性,但目前来看,AI在数学领域似乎不会遇到太大的困难。人们总说解决重大数学问题需要某种直觉性的、深层次的能力,意味着AI要达到极高的智能水平才能做到。但实际上,这就像创作艺术品一样,AI在还不能做很多其他事情的时候,就已经能在数学上有所突破了,甚至在记忆能力还不强的时候就做到了。事实证明,数学能力在AI的能力体系中,比人们预想的要靠前。

David Owen:我也比较乐观,但我觉得这个问题的关键在于定义——你得先明确什么是“主要数学问题”、什么是“独立解决”,才能做出准确的预测。不过我还是希望能给出一个合理的预测。比如,我们之前做过数学基准测试相关的研究,让数学家出了一些题,虽然那些题可能不是你说的“主要数学问题”,但数学家们表示AI能解决这些题。这对AI的进展来说是个大事,我觉得很有意义。但通常的反应是,大家会觉得“这确实让我对AI的能力有了新的认识”,但仔细想想又会发现,AI其实是通过某种“暴力破解”的方式解决问题的——尝试各种可能性,然后找到正确答案。这就像……好吧,如果有一个问题,人类觉得很重大,但AI通过某种方式解决了,大家可能会觉得“哦,它解决了,也就那样吧”。几十年前计算机攻克国际象棋就是这样,对吧?当时大家都觉得国际象棋是推理能力的巅峰,结果计算机做到了之后,人们又觉得“计算机能下棋也没什么了不起的”。所以我也不知道该怎么判断。我觉得数学对AI来说确实比较友好,我不敢断言它肯定会在未来几年解决一些千禧年难题,但如果它解决了一些看起来非常令人印象深刻的问题,我一点也不会惊讶。

Erik Torenberg:那在生物学或医学领域的突破呢?

Yafah Edelman:我们已经看到了一些突破,比如AlphaFold。导航任务对AI来说其实特别简单。说实话,AI能不能在没有人类参与的情况下,独自取得像AlphaFold那样的重大成就?这对我来说似乎是一个更大的跨越。虽然确实有这种可能性,但这里面有很多顾虑——AI需要能够实际进行实验、获取数据,并且与现实世界互动。而数学研究完全不需要这些,所以生物学或医学领域的独立突破,实际上要遥远得多。在我看来,更有可能的情况是,AI工具在生物学或化学的某些领域变得无处不在,辅助人类提升研究效率。当然,AI也有可能在没有人类参与的情况下取得惊人进展,但难度会大很多。

David Owen:同样,这里的关键也是如何界定“突破”。我觉得你说的“突破”应该不包括AlphaFold这样的工具吧?如果包括的话,那其实已经有相关案例了,对吧?AlphaFold的发明者甚至获得了诺贝尔奖。不过生物学领域有很多不同的方向,你可以让AI预测一些非常具体的东西,比如蛋白质结构,也可以开发更通用的“AI科学家”——让它浏览文献、产生新的研究想法。这两种情况都涉及不同程度的人类参与。似乎已经有一些令人印象深刻的成果出现了,但我对这个领域了解不够深入,无法判断这些成果是否达到了你所说的“突破”级别。我猜测,真正有意义的发现很快就会出现,如果现在还没有的话。但这里可能存在一个问题:AI是否会像人类研究人员那样,优先选择最有价值的新问题进行研究?我觉得大多数所谓的“AI科学家”的成果,背后都有人类在深度参与问题优先级的排序,不过我也不确定。

Erik Torenberg:最后一个问题,真正的超级智能,按照你们的定义,大概会在什么时候出现?

Yafah Edelman:我……我记得我公开说过,我讨论的众数时间线(可能比我的中位数时间线要早一些)是2045年。当时我和Jaime做播客,我们拆解了各种预测,发现到那个时候一切都会变得非常疯狂——这是我当时用的词,而那种状态在我看来就是超级智能。我认为,如果我们在不久的将来获得一个能像人类一样完成任何工作的AI,那就意味着技术扩展是有效的,能够让AI变得越来越好,而这可能意味着,距离获得比人类更优秀的AI,只剩下几步之遥了。

David Owen:预测超级智能的出现时间非常困难,而且这已经超出了我们能够合理建模的范围。我对“AI能完成任何远程工作任务”的猜测性预测,中位数大概在2035年左右。我很难想象,当AI能做到这一点,人们开始部署它、继续研究它的时候,技术会停止进步,不再变得更强大。所以我猜测,在那之后不久,按照某种定义的超级智能就会出现。但这些都非常不确定,很难给出准确的判断。

机器人技术:当前进展、瓶颈与未来潜力

Yafah Edelman:你谈了很多关于数据中心、基准测试和生物学领域的进展,但我注意到AI领域还有一个有趣的部分:机器人技术在世界模型和物理空间交互方面取得了很大的进步。你怎么看?似乎机器人技术的很多问题都可以通过纯粹的模仿学习来解决,不需要数学等方面的重大突破,只需要从大量数据中学习就行。过去几年,机器人技术和世界模型确实有了显著的进展。你对这方面有什么看法?有没有做过相关研究?我们做过相关的算力分析,研究了实际用于机器人训练的算力规模。结果发现,机器人技术的训练运行规模,比前沿AI模型的训练运行规模小100倍。所以这方面还有很大的提升空间。我觉得,直到最近,才有人真正认真地尝试大规模收集机器人技术相关的数据。如果有需要,他们可以雇一群人穿上动作捕捉服进行各种动作,已经有很多人做过这样的尝试了,不过我觉得这种情况可能正在改变。我认为机器人技术主要面临的是硬件问题和经济问题:如果建造一个机器人需要10万美元,那它未必比年薪2万美元的人类工人更有优势,尤其是在一些劳动力成本很低的国家。我不确定这里是否存在软件方面的问题,硬件方面……

David Owen:看起来确实是这样。

Yafah Edelman:我也不清楚硬件方面还有多少问题需要解决。具体来说,有些任务机器人可能确实能完成,但这些任务真的是我们希望机器人完成的吗?如果你希望机器人能够灵活行走、快速移动、举起重物并且做出快速反应,那难度就很大了。这是一个硬件问题,而且我认为目前还没有找到解决方案。

David Owen:我的印象和你差不多。人们经常讨论远程工作和体力工作的区别,我觉得很大程度上是因为机器人技术的进展确实有点滞后。甚至有一种直觉认为,物理操作实际上比虚拟任务更难,但我也不太确定。就像Jeff说的,你可能也想看看,如果机器人技术的投入规模和AI模型一样扩大,会发生什么?或许只是为了搞清楚,物理操作确实更难,还是说只是因为机器人技术的优先级比较低?

数据中心项目与AI扩展:现状、挑战与能源问题

Erik Torenberg:有没有什么我们还没谈到,但你觉得很重要,想分享给听众的?

Yafah Edelman:我们刚刚提到了数据中心相关的项目。我不知道有没有什么好的方式能详细说明,但……

Erik Torenberg:好的,那我们就来聊聊这个。你们刚刚发布了一个相关项目,不如说说你们想通过这个项目实现什么,希望大家能从中获得什么?

Yafah Edelman:好的。我们找到了13个目前能找到的最大的数据中心,其中包括美国几个主要实验室的设施。我们获取了这些数据中心的许可证信息,还拍摄了新的卫星图像——覆盖了所有这些数据中心。我们根据它们的冷却基础设施、上线时间和未来规划,估算出了每个数据中心的算力。所有这些真实世界的数据,都在我们的网站上免费提供给大家。做这个项目是为了让大家了解正在进行的大规模基础设施建设,以及建设的速度。其中有些情况让我非常惊讶。比如,我们发现最有可能拥有第一个千兆瓦级数据中心的,竟然是Anthropic——这完全出乎我的意料。Anthropic和亚马逊在新卡莱尔合作的“雷尼尔计划”(ProjectRainier),似乎按计划会在一月份上线,紧随其后的是“巨人二号”(Colossus2)数据中心。我们还了解到了很多大型数据中心的具体规划,而不仅仅是营销层面的宣传。有些人会随便抛出一些惊人的数字,但我们发现,真正在认真推进、已经获得许可证并且正在建设电力基础设施的,是微软在芒特普莱森特的一个项目——他们称之为“微软费尔沃特”(MicrosoftFairwater),这个数据中心至少有一部分是供OpenAI使用的。它将消耗的电力……虽然不如纽约市多,但我估计能达到纽约市电力消耗的一半以上。

Erik Torenberg:是什么限制了我们大幅扩大集群规模?是成本、供应交付时间、需要其他工程突破,还是电力问题?

Yafah Edelman:我觉得大家普遍误解了,认为有什么东西在限制我们扩大规模。实际上,只要有资金,我们就在尽可能快地扩展。我猜大家可能希望所有集群现在就建成,但目前的扩展速度已经相当快了。你可以看看这些数据中心,我刚才提到的Anthropic和亚马逊合作的那个,消耗的电力几乎和印第安纳州首府一样多。其中一些数据中心的建设周期是两年,要建造一个消耗城市级电力的设施,这本身就很疯狂。而且很可能,大家现在不想购买芯片,而是想等待更好的芯片问世。很多人说扩展集群很困难,但我觉得这只是一种错觉。之所以会有这种说法,是因为大家不得不比平时多花一些钱。你不能再使用那些旨在慢速提供廉价电力的传统流程,必须购买一些平时不需要的设备,花费比平时更多的钱,但这些额外成本还不足以减慢扩展的速度。而且这些成本和GPU的成本相比,根本不值一提。我实际的看法是:扩展集群并没有太大的麻烦,这些建设计划的推进速度已经非常快了。现在不确定的是,人们是否真的有足够的财力和意愿,以更快的速度推进。

Erik Torenberg:当人们说能源是提升AI能力的主要潜在瓶颈时,你并不担心这会成为一个长期、可持续的瓶颈吗?

Yafah Edelman:我不这么认为……人们抱怨能源问题,是因为他们不能再使用传统流程——接入电网,等待四年后获得廉价电力。但归根结底,有很多昂贵的能源解决方案可以选择。比如现在就可以选择太阳能加电池的组合,交付时间相当短。虽然成本可能是常规电力的两倍,但仍然远低于GPU的成本。所以如果必须的话,大家都会选择这种方案。你会看到很多人会采取这些成本稍高的应急措施来启动数据中心。我们常见的一种情况是,在数据中心接入电网之前就开始运行。阿比林的数据中心就是一个例子,xAI的“巨人一号”(ColossusOne)更是典型——他们只是在寻找昂贵的方式来绕过电力接入的问题。你当然可以抱怨,因为能用上廉价电力当然更好,没人习惯用这么贵的方式。但归根结底,解决方案是存在的,尤其是对于AI行业那些愿意花钱的人来说。所以我不认为能源会成为一个显著的瓶颈。

政策回应与终极展望:公众反应、政府角色与未来不确定性

Erik Torenberg:也许我们可以就此结束了。如果这些AI系统变得像我们讨论的这么强大,我很好奇政治体系会如何回应。我想知道你是否认同阿什(Ash)和布伦纳(Brenner)的观点,即可能会出现某种形式的国有化。但总的来说,你预期政府会如何回应?考虑到AI已经这么强大了,却还没有成为政治话语的核心议题,这一点非常引人注目。你怎么看待这个现象?

Yafah Edelman:我预期……回到我之前提到的那个设想,如果六个月内失业率上升5%,公众的反应将决定一切。一旦这种情况发生,人们对AI的态度会变得非常强烈。我认为,大家会在一些我们现在根本想不到的事情上形成强烈的共识。我记得新冠疫情期间,各国在几周甚至几天内就通过了数万亿美元的刺激计划,速度非常快。我不知道AI会引发什么样的反应,但我觉得AI的发展和其他AI相关事物一样,都是指数级的——这意味着如果当前的趋势持续下去,人们对AI的关注会很快从“有点关心”变成“高度关注”。我只是不知道最终会走向何方。但我可以肯定的是,无论结果如何,大家都会突然同意做一件一年前我们认为完全不可能的事情。我不知道这件事会是什么——可能是国有化,可能是暂停AI发展,可能是加速推进,也可能是完善失业救济制度,谁知道呢?但我认为一定会有某种强烈的回应。

David Owen:这种回应会来得非常快。你提到政府对AI的兴趣可能比预期的小,但目前AI的实际影响确实还没那么大。我觉得关注度正在上升,但AI目前还没有强大到足以成为核心政治议题的程度。不过政府其实已经在大量讨论AI了,对吧?各种硬件制造商和AI公司的人都会和国家元首会面,各国也在制定AI战略等等。所以国家政府显然会深度参与其中,问题只是他们会以何种方式参与。是的,具体会怎样,我也不太清楚。

Yafah Edelman:我认为目前AI行业的收入和财务数据都是每年翻倍甚至三倍增长。我的默认假设是,政策制定者和政府对AI的关注也会遵循类似的趋势,每年翻倍或三倍增长。这意味着,如果趋势持续,未来AI会受到极大的关注。同时也意味着,现在的关注度已经比去年高很多了,只是不会突然从“很少关注”跳到“全民关注”——尽管我们的推进速度已经相当快了。

Erik Torenberg:我觉得我们已经做了足够多的预测了,明年年底一定要请你们回来,看看这些预测的进展如何,然后再为下一年做预测。

Yafah Edelman:非常感谢你们邀请我们参加播客。

David Owen:谢谢,非常感谢邀请。

原文:The 2045 Super intelligence Timeline : EpochAI’s Data-Driven Forecast

https://www.youtube.com/watch?v=TbFSGiQdCaw

编译:Yesenia Ye

请注意,本文编译自文末载明的原始链接,不代表ZPotentials立场。如果您对本文有任何想法或见解,欢迎在评论区留言互动探讨。

ZPotentials将继续提供更多关于人工智能、机器人、全球化等领域的优质内容。我们诚邀对未来充满憧憬的您加入我们的社群,与我们共同分享、学习、成长。

暂无评论内容